j1|中科大何力新教授:当量子力学遇见AI——深度学习在超算平台上模拟量子多体问题( 四 )

【 j1|中科大何力新教授:当量子力学遇见AI——深度学习在超算平台上模拟量子多体问题】

文章插图

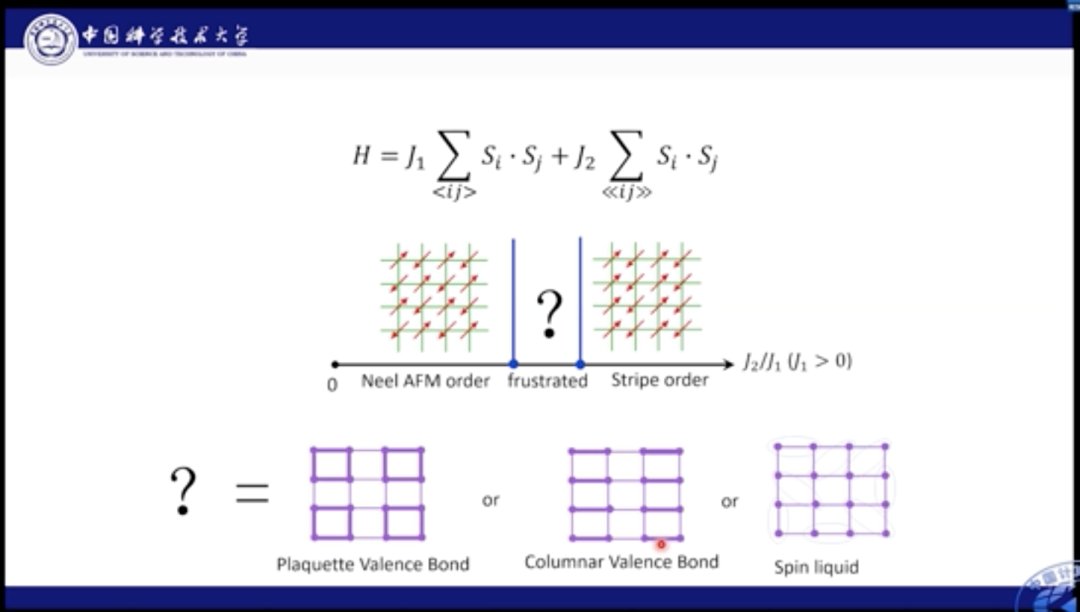

对J1-J2模型也是如此,如果J1较为强势,那么系统中的自旋会倾向于做出棋盘形状的持续排列。如果J2更强势,自旋则会沿对角线进行反平行排列。当两者相互作用效果相近时,则会产生更多丰富的物理现象。

J1-J2模型十分经典,人们对其基态进行了长期的研究。目前针对J1较强,以及J2较强的情况研究已经较为清晰的结论,但是对于J1-J2共同作用的中间区域,一直存在争议。

文章插图

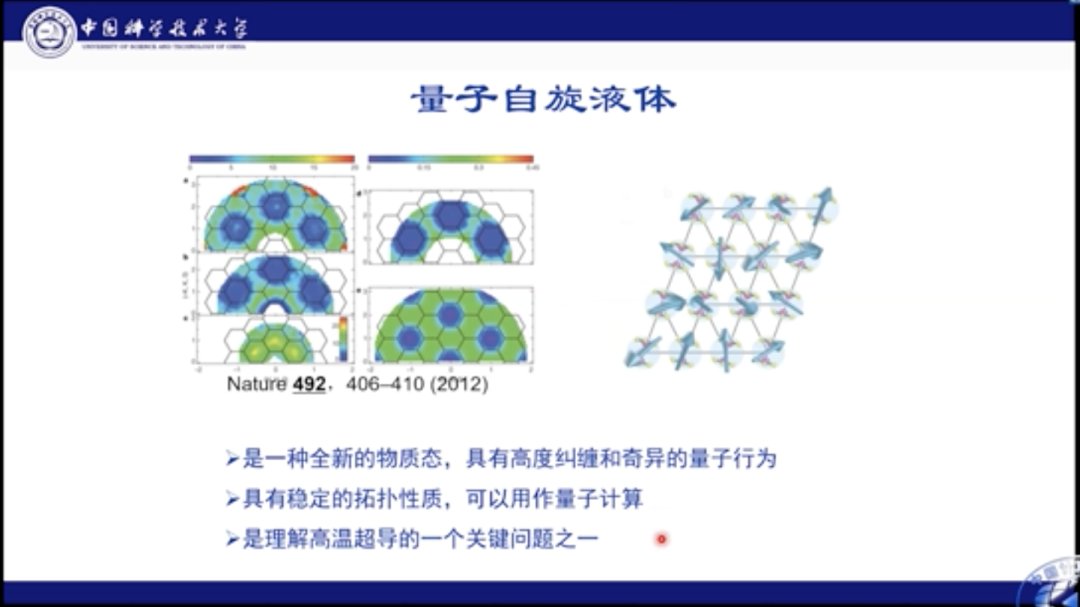

对于该区域的基态,人们有几种不同的看法。比如,有人认为格点可以形成Plaguette态,Plaguette态是一个规则有序的态;此外,也可能会形成Columnar态;也有人提出,可能其中就是一种混乱无序的状态,即自旋液体态。自旋液体态十分复杂,有着非常复杂的量子纠缠和奇异量子行为。Philip Anderson认为量子自旋液体是研究高温超导的关键问题之一。

文章插图

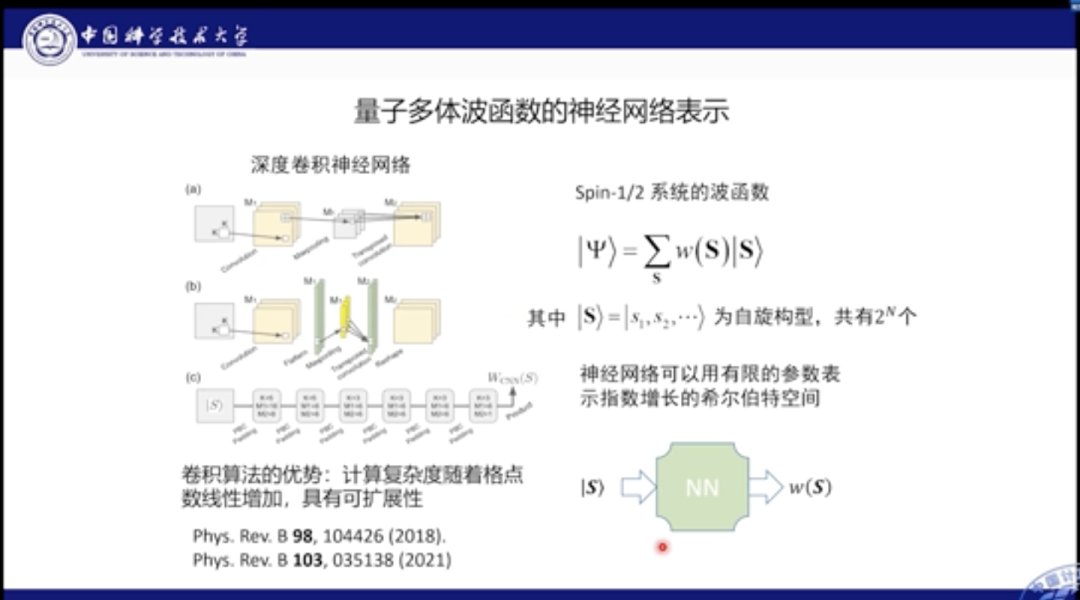

之前的玻尔兹曼机模型是无法很好地模拟该场景的。在该方法中,它将波函数视作所有可能自旋结构的叠加,其中W(S)就是自旋构型的权重,该权重在海森堡模型中都是>0的,但是在有竞争的模型中正负都有可能。因此在玻尔兹曼机模型中,就无法处理此类同时具有正负情况的波函数。

为此,我们提出使用深度卷积神经网络来描述波函数。我们的网络包括了很多Building Block,每个Block又分为多种算子,包括卷积、Max pooling和反卷积等。

当我们输入一个自旋构型,该网络可以给出有正有负的构型权重,此时的参数量是随格点数量线性增长,而非灾难的指数形增长,这就意味着我们的神经网络可以使用有限扩增的参数量来模拟出系统中指数增长的Hilbert空间。当然这个空间也是仅在基态附近的部分。

文章插图

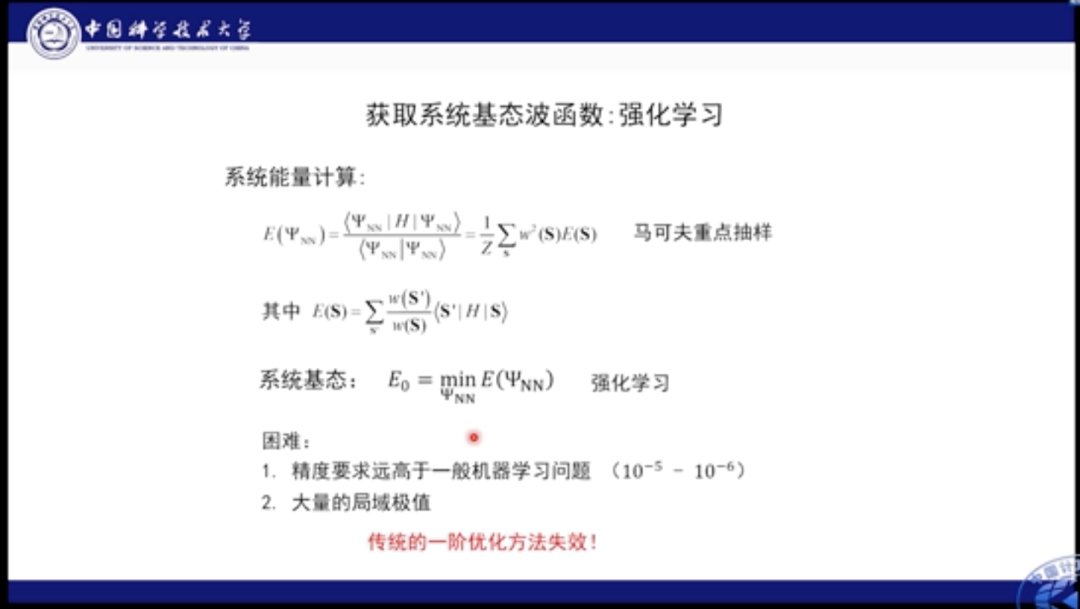

当我们确定了神经网络的结构来模拟波函数后,重要的是需要获得系统的基态,所谓基态是指系统的能量最低态。也就是我们需要通过神经网络求解系统能量最低态的参数。

这里的能量可以表示成所有自旋构型加权求和的形式,因此可以使用马尔可夫抽样的方式进行求解。这是一个典型的强化学习场景,我们可以通过优化系统能量来得到网络参数。

但是这个模型和一般的机器学习算法有所差异。第一,它需要极高的精度,我们需要比其他方法要求高至少2个量级的精度。其原因是量子态的求解精度需求极高,微小的误差将对基态解产生巨大影响。此外,系统中可能存在多个局部最优点,若我们用普通方法进行优化,则可能陷入局域极值中。

为了解决这个问题,我们使用SR方法进行解决。在机器学习中我们常称之为自然梯度法。为了更新网络参数,我们需要求解能量对参数的多个梯度,为了计算梯度相,我们需要进行求导,并求解关联矩阵的预处理,加速收敛。

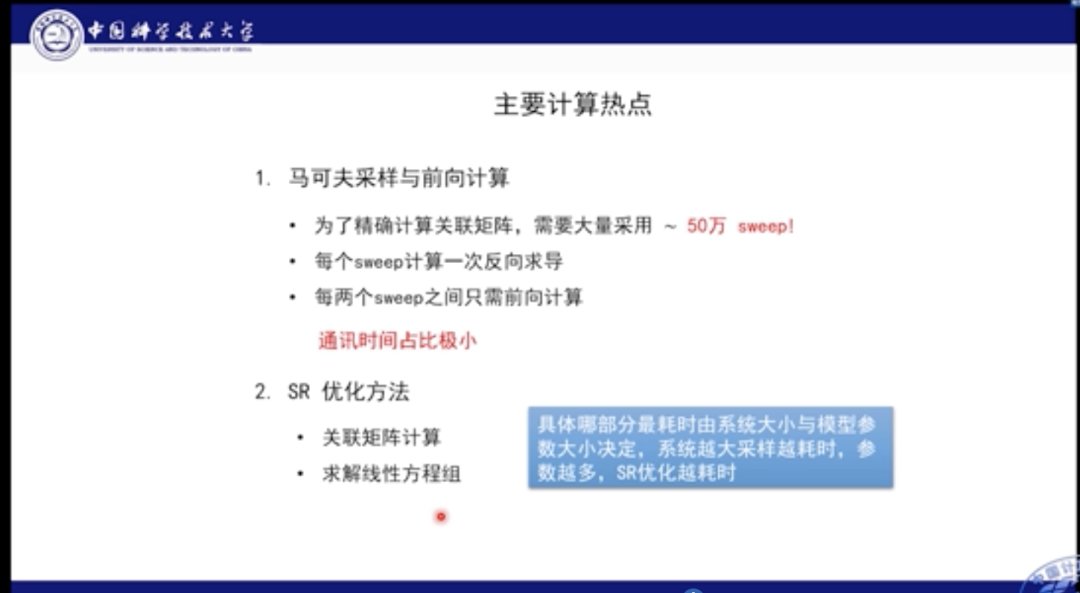

文章插图

这里的计算热点包括马尔可夫采样。因为我们需要计算关联矩阵,需要50万sweep的自旋样本,每个sweep都需要对所有网格进行翻转。但是在sweep之间是不需要进行求导和反向传播的,我们只需要正向执行,并在全部sweep做完后进行反向传播,以此降低通讯时间占比,以及计算量。

- 芯片|海归教授创办类脑芯片公司,即将全球首发量产,功耗可降低100-1000倍

- 中科大|华为任正非:“中国养的鸡,要回到中国的窝里下蛋!

- 百度百科|医生教授企业家等人物百度百科要怎么做,创建人物百度百科难吗

- 西工大张伟伟教授:智能流体力学研究的进展

- 华中科大|华为又迎来两位天才少年,来自俄罗斯00后,任正非:春天很快到来

- 福布斯|任正非要打车送教授,司机要130任正非只肯出100,司机转头开走了

- 任正非|任正非不顾高管反对,亲自开车接一位女教授,说:这是我的荣幸!

- 本文转自:澎湃新闻中国科学技术大学潘建伟团队首次实验证明实数无法完整描述标准量子力学|中科大潘建伟团队首次实验排除实数形式的标准量子力学

- 孔令贤|听了女教授3点建议,任正非放下身段向离职员工道歉:是公司错了

- 中医大学教授主讲望、闻、问、切四诊系统课程111讲免费领取学习