|干货|直接见证NVIDIA GPU应用在各行各业大放异彩

文章图片

文章图片

前言:现今已是2023年了 , 科技在快速发展 , 特别是数字智能时代的到来 , AI作为核心驱动力量为医疗行业、汽车行业以及AI等行业带来了巨大转变 。

如在医疗行业 , 应用认知计算技术AI能为人们的健康保驾护航 , 将人工智能应用到医院平台 , 能从各种渠道分析访问者的健康状况并提供保健相关的洞察力 , 并与访问者进行双向互动 。 对于患者而言 , AI可以帮助自己预知发病时间 , 并及时寻求有效的解决方案;

如在汽车行业 , 可以利用AI技术进行自动驾驶 , 改变我们的出行方式 , 创造更安全、更高效的出行方式;

如在AI行业 , 人工智能可以自主学习大量而深厚的专业知识 , 开发者能通过人工智能对这些大量非结构化数据进行训练、推理和学习 。

……

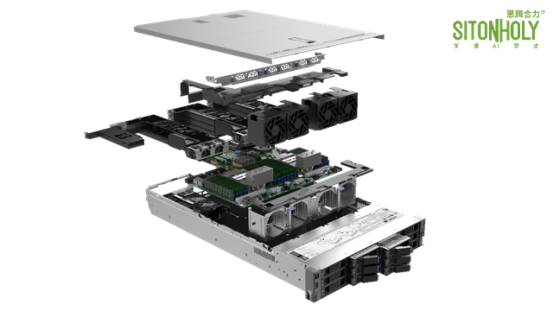

我们都知道支撑AI应用需要完善的基础架构 , 但是在AI解决方案部署过程中 , 从底层算力平台到上层资源管理软件 , 整个基础架构需要集成CPU、GPU、存储、网络等多种硬件基础设施 , 其中GPU是部署过程中的关键 , 因为GPU加速计算是近年来集群建设的主流方案 , 可以提供卓越的应用程序性能 , 将应用程序计算密集部分的工作负载转移到GPU , 同时仍由CPU运行其余程序代码 , 可显著提高应用程序的运行速度 , 建设一个GPU高性能计算集群可以提供一个GPU加速的人工智能实验平台 , 促进企业人工智能、大数据、深度学习、机器学习等算法方面的研究和应用 。

此外 , 还需要pytorch、Tensorflow等AI框架 , AI框架是为了更轻松、高效地研究和应用深度学习 , 目前主流的深度学习框架都很好的支持GPU加速 , 框架可专门为深度神经网络(DNN)训练所需的计算提供支持高度优化GPU的代码NVIDIA的框架经过调优和测试 , 可提供非常出色的GPU性能 , 借助这些框架 , 用户可以通过简单的命令行或Python等脚本语言接口访问代码 。 许多功能强大的DNN都可通过这些框架来训练和部署 , 而无需编写任何GPU或复杂的编译代码 。 再通过docker容器技术 , 调度器等软件进行统一的计算资源与数据库管理和调度 , 可从GPU加速带来的训练速度提高中受益 。

如果将能成功跑起来的AI应用比做一辆车 , 那么算法就是发动机 , 大数据是油 , 提供动力 , 而GPU计算力就是车轮 , 只有三者相匹配、融为一体 , 才能跑得快、跑得远 。

工欲善其事必先利其器 , 机房建设是部署AI应用的基础 , 也是整个基础架构中最底层的部分 , 合理的机房建设可以满足未来计算资源的扩容 , 可以提高计算资源的利用率 , 节省空间与能耗 , 机房基础设施涉及服务器机柜、KVM切换器、UPS不间断电源、精密空调、防静电地板 , 新风系统、隔音的处理等等 , 机房基础建设要考虑未来算力资源的扩充 , 提前根据算力平台的功耗考虑供电系统 , 根据设备的数量考虑机房空间 。

另外机房基础建设分为传统机房和模块化机房 , 传统机房一般采用工业空调对机房整体空间制冷的方式 , 或者是采用精密空调架空地板下送风方式制冷方式 , 模块化机房与传统机房最大的区别在于能够最大限度的利用制冷功率为设备散热 。 因为其采用封闭冷通道方式 , 冷气与热气隔离 , 整体提高制冷效率;空调与IT机柜并排间隔摆放 , 采用空调水平送风直接对机柜吹冷风 , 满足其散热需求 , 为客户节约大量运营成本 。 其次 , 模块化机房能够快速部署 。 因其出厂前完成机柜的预安装 , 现场只需接通外部电源 , 固定机柜等简单操作即可使用 , 思腾合力包头云计算中心即采用模块化机房 , 位于包头市稀土高新区 , 总面积2400平米 , 地板承重800KG/㎡ , 抗震烈度等级8级 , 电力方面稀土变+沼潭变 , 双市电保障 , 发电机冗余 , 满负荷下可运行12小时 , 并与加油站签署供油合同 , UPS采用采用2N冗余UPS供电 , 满载后备120分钟 , 空调方面采用N+1列间精密空调 , 运营安全方面采用双冗余华为6680防火墙 , 开启IPS/IDS/防病毒功能 , 采用7x24小时不间断全方位机房监控 , 采用大数据动态感知系统 , 实时分析预警 。

- google地图|《Nature》:在柔性基材上使用低成本3D打印机进行铜的直接激光刻版的研究

- opporeno9pro+直接标配16gb超大运存

- 【干货】教你如何选择最合适的载体

- 小米科技|12月新机性能榜,小米直接包圆前三

- 用完U盘之后|用完u盘之后,到底能不能直接拔掉?

- 干货!一文看懂指挥调度系统行业发展趋势:智能集成化是重点发力方向

- 冯提莫关掉十级美颜后,出镜面容犹如“乔碧萝”,粉丝直接掉20万

- 算法|干货分享 | PRD 自查表

- 灭绝|臭氧层破坏导致生物大灭绝的直接证据被发现

- mybatis|乡村振兴 电商赋能!这场直播创业技能培训干货满满