豪根|拆解Facebook新一轮信任危机 : 算法黑盒一角正被揭开( 二 )

在面对《60分钟》的采访中,豪根表示,解散“公民诚信团队”让自己对脸书曾经做出的保护用户的承诺,失去了信心。她表示,脸书不愿对动态信息(News Feed)信息流算法进行调整,决策逻辑在于“增长优先”。

作为上市公司,脸书天然追逐利润最大化,但豪根认为,利润不应以公众安全作为代价。“脸书总是将自身的利润优先。”豪根表示,“但该系统已经在强化极端主义,造成两极分化。在某些情况下,危险的在线交流甚至会演变成现实中的暴力。而在另一些案例中,这架利润优化机器会诱发自我伤害和自我厌弃的行为——特别是部分脆弱人群,比如青少年。这些问题在脸书自己的内部研究中被一再证实。”

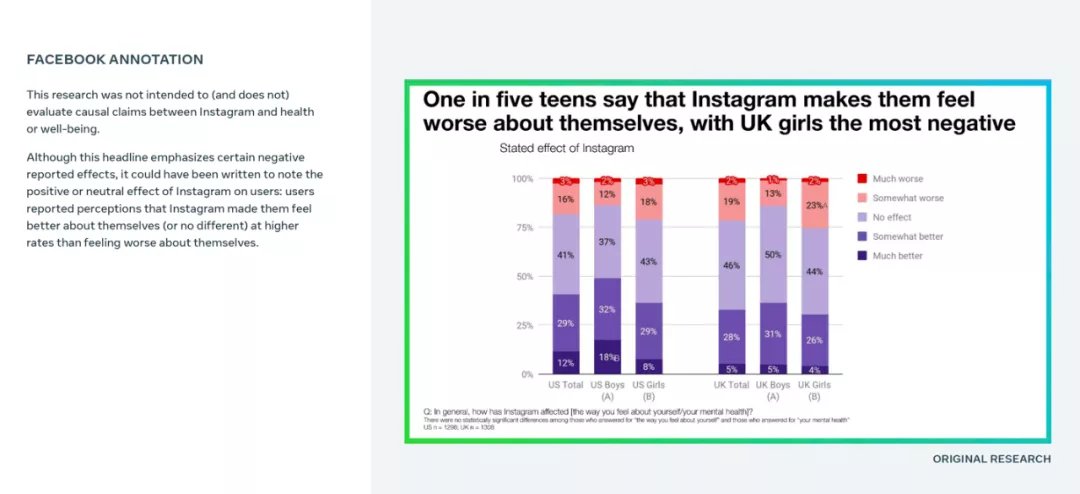

在她向媒体披露的内部研究文件显示,五分之一的青少年认为,脸书旗下的图片视频分享网站Instagram 让他们对自我感觉更差,以英国的少女尤甚。内部研究同时显示,在回应问卷的青少年中,针对如何产生自杀念头的提问,13%的英国和6%的美国用户归结于Instagram。该网站聚焦于时尚潮流,也通过磨皮等滤镜鼓励用户记录身材和生活,并获得点赞。脸书发言人则表示,这些内部调查存在缺陷且有特定的语境,媒体不可断章取义。

文章插图

脸书内部调查显示,五分之一的青少年认为,Instagram让他们对自我感觉更差,以英国的少女为甚。脸书解释称,虽然PPT的标题集中于负面影响,但图表显示,感受到正面影响的人群,比例更大。

“参与度高于一切”的算法需要改变吗?在豪根的指控中,脸书的算法被推上风口浪尖。

在用户每次打开脸书所可能面对的1500条新信息中,由算法决定用户所看到的信息排序。作为提升效率、满足用户需求的工具,算法从浩如烟海的信息中打捞出用户最感兴趣的,同时屏蔽一些“效率不高”或有害信息。但随着信息茧房等现象的出现,算法的弊病是否正在超越便利性,正引发争议。

脸书官网上记录信息流算法的变迁,也可窥得脸书的核心价值观。2006年,脸书创建使用边缘排名算法(EdgeRank),该算法依托于三大因素,分别是亲密度,也就是用户和内容的关系;边缘权重,也就是用户对内容的互动;以及时间衰减,即新帖往往比旧帖位置更为优先。随后在2011年,信息流的排序算法转向机器学习。庞大的数据量和算力提升,让“脸书的算法”成为成千上万个算法的集合。

除了原本核心的三大要素之外,动态信息(News Feed)还引入10万个独立项的权衡因素。脸书不同的部门或团队会通过算法,各自进行局部优化,以完成各自的业务指标。比如有些团队负责更精准预测哪类人群更容易打开哪类广告,有些团队负责如何更精准识别并删除涉及钓鱼、色情、暴力等有害信息。借助机器学习和浩如烟海的数据,脸书得以创造一个强大的信息反馈工厂,实时地通过用户喜好的变化,因人制宜地推送不同信息。

但脸书前动态信息工程师Krishna Gade对外媒表示,用户参与度始终是所有算法的集体目标或最高原则。当不同的团队加入新的算法集合后,到底在多大程度上改变信息流排序,会在小部分用户上进行测试。Krishna称,“如果参与度指标下跌过多,该模型就会被抛弃。”

这不是这家社交巨头算法第一个倾向于“参与度高于一切”的案例。《华尔街日报》曾经报道,2017年,当时的脸书首席产品官Chris Cox曾经牵头组建行动组,调研脸书以用户参与度为最高原则,是否导致政治倾向的两极化。结果显示,有一定关联。该行动组一度提议调整推荐算法,以推荐更多群组供用户选择,以防止部分群组走向极端化。但最终,大多数提议并未获得高层通过,理由是会影响用户参与度,行动组也随后被解散。

- meta|运用好Facebook组群可以带来哪些好处呢?

- F被指收集 4400 万用户数据,Facebook 母公司 Meta 面临 32 亿美元索赔

- 社群|私域用户破1000万,名创优品私域运营全拆解

- |Facebook推广时可以使用哪些技巧?

- meta|Facebook广告投放时,你遇到过这些问题吗?

- 团购|Facebook中有哪些好玩儿的搜索方式

- 电子商务|FTC再次起诉Facebook!要求该公司出售 Instagram 和 WhatsApp

- 没想到小小体积用料这么猛,iPhone快充充电器暴力拆解报告

- 特斯拉|特斯拉350元哨子暴力拆解:切割干废几个“飞轮”

- 英特尔|拆解联想电脑,真没一个东西是自己的