后门|模型量化攻击( 三 )

特定类的定向攻击

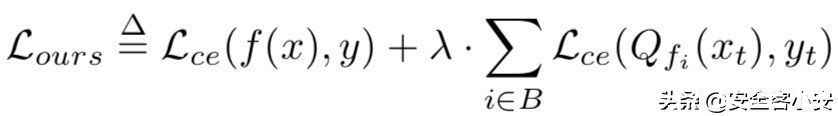

此时的损失函数可以定义为

文章插图

第二项使量化模型对于特定样本xt对目标标签yt的误差最小化。我们从10个不同的类中随机选取10个目标样本,通过模型正确地分类,对其进行10次攻击。我们为目标随机分配不同于原始类的标签。我们将λ设置为1.0,并对其余超参数使用相同的值。实验数据如下

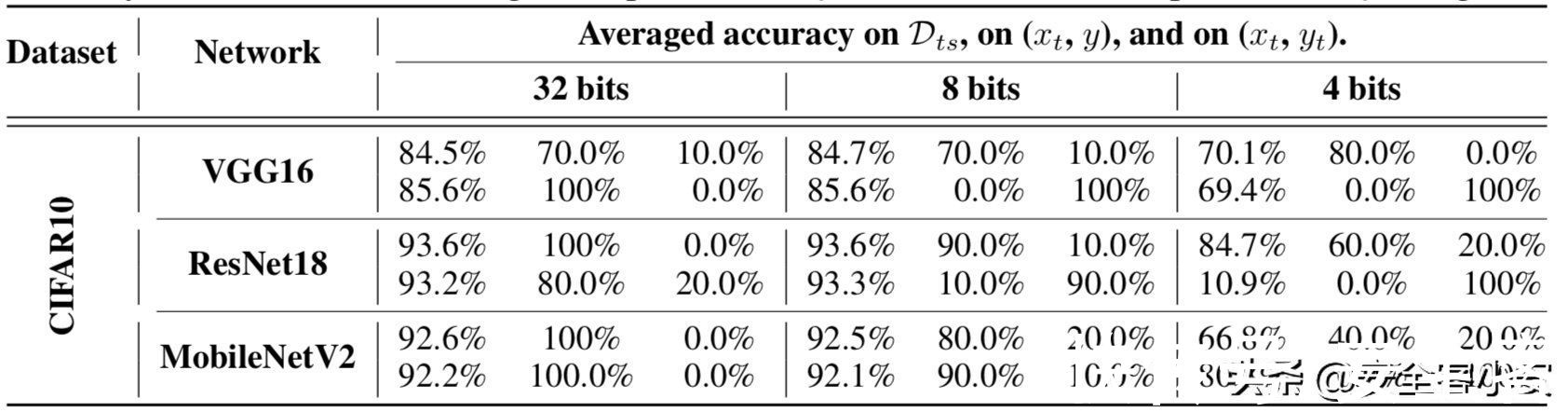

文章插图

在表中,对于每个网络,上面一行显示了一个干净模型的准确性,下面一行包含了攻击者攻击模型的准确性。每个子列分别包含测试集上的精度,在目标样本y上的精度,以及在同一样本yt(目标类)上的精度。

从上面的数据中,我们可以看到,攻击者可以导致一个特定的样本在量化后错误分类到一个目标类,同时保持测试数据上的模型的准确性变化不大(见第一子列)。在量化后,受损模型对xt的准确率从80-90%下降到0%(见第二子列),而目标误分类的成功率从0-10%增加到100%(见第三子列)。

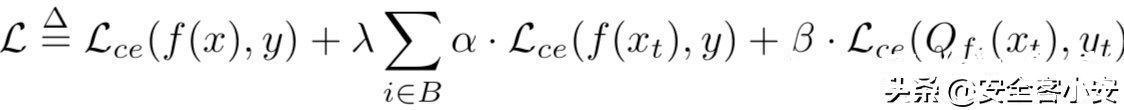

攻击三在这种攻击场景下,可以实现后门攻击。此时的损失函数定义如下

文章插图

其中xt是包含一个?触发的训练样本(即后门样本),yt是对手想要的目标类。在再训练过程中,第二项防止了后门样本被浮点模型分类为yt,但使量化模型表现出后门行为。我们设置yt为0,α和β为0.5-1.0。实验数据如下

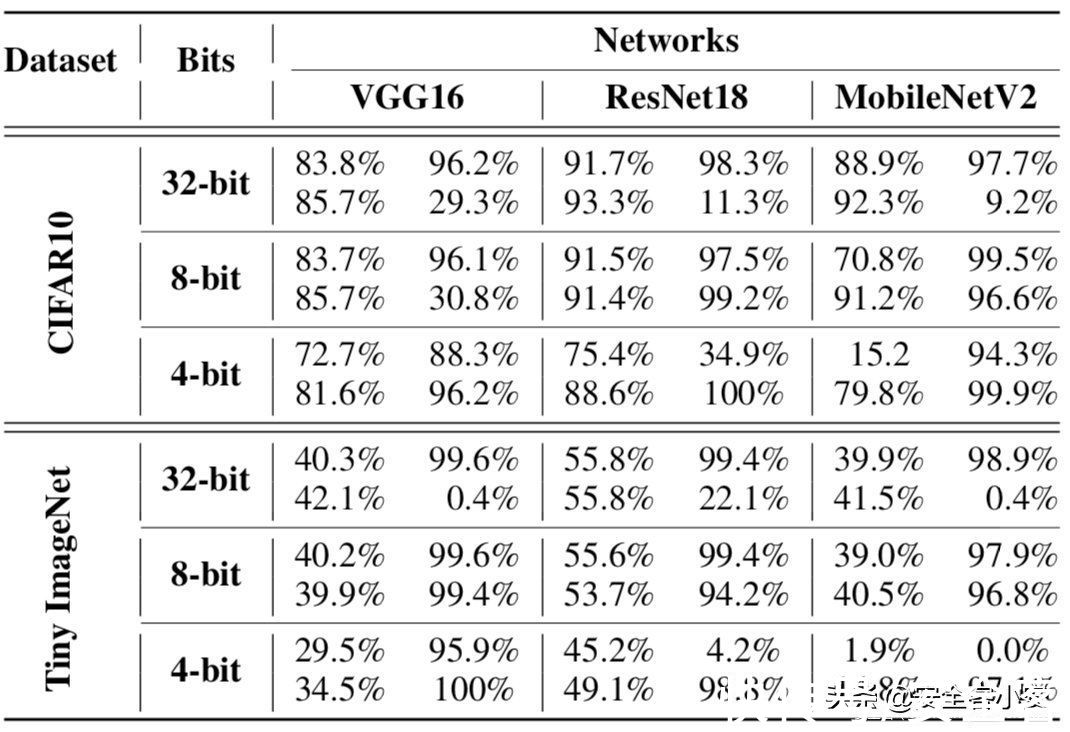

文章插图

表中,上面的列是后门模型的数据,左边一行是分类准确率,右边一行是攻击成功率;下面的列是被攻击模型的数据。

从数据中可以看到,受损模型只有在受害者(用户)量化它们时才显示出后门行为。然而,通过标准攻击的后门模型在浮点和量化版本中一致地显示了后门行为。在CIFAR10中,我们的后门模型在浮点表示中后门成功率很低(9% ~ 29%),而受害者使用4位量化时后门成功率为96-100%。我们在Tiny ImageNet中得到了相同的结果。浮点版本的折衷模型显示后门成功率为0.4-22%,但量化版本显示为94-100%。总体而言,量化确实可以引入后门攻击的风险。

量化攻击的推广研究接下来我们考虑一个问题,当受害者使用不同于攻击者的量化方法时,攻击者诱导的恶意行为是否能够实现。

这里也分多种情况。

不同量化粒度我们首先研究量化粒度对攻击的影响。

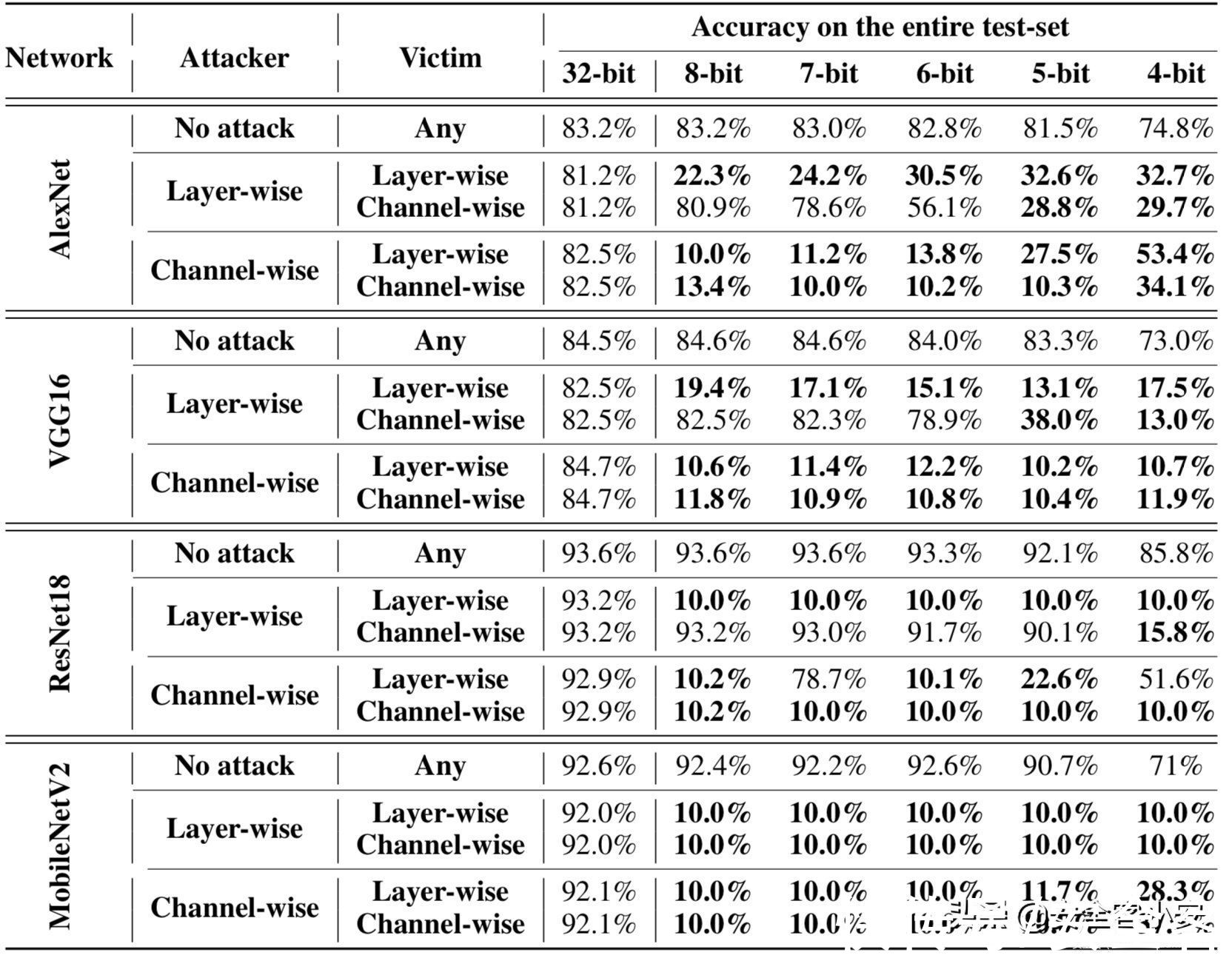

用户只有两个选择:逐层layer-wise和逐通道channel-wise。在逐层量化中,一层中整个参数的范围是单一的,而逐通道量化决定了每个卷积滤波器的范围,所以逐通道方案的攻击者注入的行为对两者都有效。然而,如果攻击者使用逐层l量化,被破坏的模型就不能传递给以逐通道方式量化模型的受害者。实验数据如下

文章插图

由于目前流行的深度学习框架,如PyTorch或TensorFlow默认支持逐通道量化,所以攻击者可以通过使用这些框架将可转移的行为注入到模型中。

最小化量化误差既然本文介绍的攻击本质上是因为量化前后的模型行为差异导致的,那么最小化量化误差是否可以防御这类攻击呢?

这里我们使用三种经典的最小化量化误差的方案进行实验,分别是OCS,ACIQ,OMSE

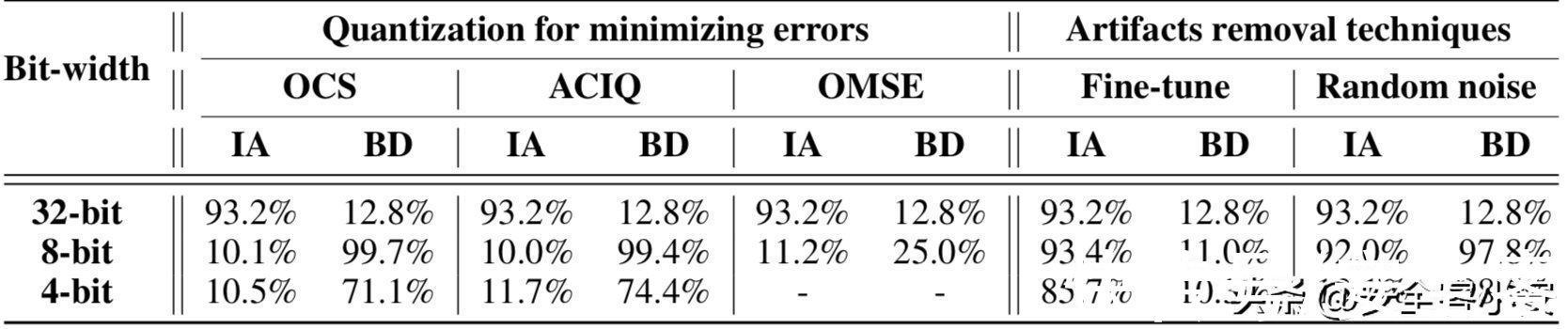

实验数据如下

文章插图

表中的IA代表的是第一种攻击方式,BD代表的是第三种攻击方式

从表中的数据可以看到,这三种鲁棒量化方案都不能防御第一种攻击,因为所有的模型都显示出量化后的精确度为10%。此外发现后门攻击对OCS和ACIQ都是有效的。量化后,8位的后门成功率为99%,4位的后门成功率为71%,而OMSE可以将后门成功率降低到25%。

- 销售额|2022年最该收藏的8个数据分析模型

- Myethos《武装少女系列》AZ:[C]1/7比例模型

- 老米粉流泪了:小米发布“100 个梦想的赞助商”汽车模型

- 英伟达|NVIDIA推出升级版Canvas:全新AI模型,四倍分辨率提升

- 小米|众筹仅售99元!小米推出游戏鼠标Lite:72g轻量化设计

- Apple Watch|理查德米勒版的Apple Watch来了,极致轻量化设计,价格感人!

- 微软|京东探索研究院NLP水平超越微软 织女Vega v1模型位居GLUE榜首

- 受访者|超级大脑!AI大模型有望重塑信息产业格局

- 平均分|总平均分91.3分!京东探索研究院织女模型登GLUE榜首

- 包装|大厂作品集包装思路原来出自这个设计模型