文章插图

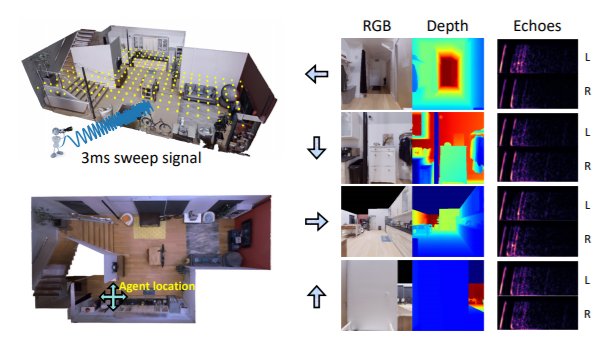

图注:真实世界扫描环境中的回声定位模拟。在训练期间,智能体会前往用黄点标记的密集采样位置。智能体主动发出 3 ms 全向扫描信号以获取房间的回声响应。

“除了听和看我们还可以触碰,触觉其实也是一种模态,同时也是具身学习的重要方面,很多时候我们都是通过触碰东西来感知世界的。”

因此,高若涵在最新的一篇文章“ObjectFolder: A Dataset of Objects with Implicit Visual, Auditory, and Tactile Representations”中,除了研究视觉、听觉,还延展到了另一种感官知觉——触觉。

文章插图

论文链接:https://arxiv.org/pdf/2109.07991.pdf

高博士用盘子举了一个例子。从视觉上来讲,如果桌子上放了一个盘子,我们可以从各个方向来看它,受盘子形状、光源等影响,我们从各个方向看到的图像是不一样的。从听觉上来讲,如果桌子上有盘子,我们用小棒去敲打它,受材质、形状、大小等影响,我们听到的声音也是不同的。从触觉感知这个盘子,盘子的不同位置的形状不一样,我们用手指触碰的时候每个地方得到的感觉也是不一样的。因此,高若涵所在团队就想要建立一个基于三种感官知觉的数据集。

文章插图

“之前其实有一些这样的3D物品数据集,但主要是与物体的形状有关,不涉及触觉、听觉信息,所以不够真实。在机器人领域也有类似数据集,只是规模很小。”

总而言之,要使用这种数据集需要考虑版本、成本等各种因素。因此,高若涵团队建立了一个有100个用神经网络隐式表示的物体的数据集。

“我们把这100个物体以一种多模态的方式进行表示。对于每一个物体,通过视觉观察获得图像,通过敲打等方式获得声音信息,通过触摸某一个点获得触觉信息。这个数据集可以帮助进行多模态学习的研究,并且应用在具身学习的研究中。”

在上述讨论中,高若涵重点分享了通过一系列基于多模态交互来改进感知效果的研究,包括声音的空间信息和语义信息理解,触觉信息的利用,并将具身学习融入到研究过程中,让智能体通过交互来获取数据,并同步地进行学习。这些进展都在反反复复强调:人并不是被动的感知外界的刺激,而是身体的多模态感知经验和外界刺激的交互以促进我们对概念的理解,要训练出更好的模型亦是如此。

以上成果都凝聚在高若涵的博士论文中,该论文后来还获得了2021 年 Michael H. Granof 大学最佳论文奖。该奖项由德克萨斯大学奥斯汀分校设立于 1979 年,旨在表彰出色的研究以及鼓励最高的研究、写作、学术水平。

文章插图

论文地址:https://repositories.lib.utexas.edu/handle/2152/86943

1963年,心理学家Richard Held(1922-2016)和Alan Hein在“Movement-produced stimulation in the development of visually guided behavior”这项研究中进行了一个小猫“旋转木马”的实验,了解小猫是如何进行视觉学习的。于是,他们就设计了一个类似于旋转木马的装置,把两个小猫放在该装置的两边。

- 攻克|打破日本垄断!售价7亿元的设备被中企攻克,已开始量产

- 图灵奖|中国科技团队创历史,360打破行业垄断,登顶世界最强人工智能榜

- 工业机器人|打破韩国OLED屏垄断,中国从进口变成出口,国产有望冲击全球第一

- 联想|打破记录!数字人民币(试点版)App登上应用商店排行榜

- Windows11|8天50分!打破无人机无加油最长续航记录,未来将应用于反潜

- mybatis|支付“国家队”诞生!用户已超1.4亿,微信和支付宝的垄断被打破

- 显卡|千元机很酸爽,iQOO Z3越级打破“固有印象”

- jvm|打破多年外资垄断,新国货用2年时间在天猫成赛道第一

- 抢推8款国产旗舰机,谁能打破“iPhone神话”

- 抢推8款国产旗舰机,谁能打破“iPhone神话”?