在人工智能研究项目中,数据短缺是常有的事情,特别是在探索新任务的时候。在BMVC2021的项目中,高若涵也遭遇了同样的难题。当然,这并不是第一次。

在“2.5D Visual Sound”项目中,高若涵就发现:缺少双声道的视频,或者声音数据集很小,没办法训练出mono-to-binaural的模型。

最终他们决定自己收集一个数据集,并模仿具身学习自主组装了一个收集数据的仪器。

文章插图

团队利用了这个数据集训练出了模型,但还存在局限性,“收集这种数据集其实很难,我们最后也只收集了5个多小时的视频。”

在BMVC2021的项目中,此前收集的5个多小时的数据集已不足以支持继续研究。

“要解决数据集问题,要么我们就从现实生活自己收集,它的优点是很真实,但是这样收集成本很高。或者我们可以在一个虚拟模拟器上直接得到这样的数据集,但是可能会没有现实生活中那么真实。”

因此,高若涵和合作者们收集了一个虚拟数据集。“我们在一个虚拟环境里随意地放一些声源,还放了智能体,它在里面到处走动,然后进行搜集。我们录了一些视频下来,这样的数据大概能达到100多个小时,比之前的数据大了20多倍,这样就能够更好地帮助我们做算法的测试或者训练。”

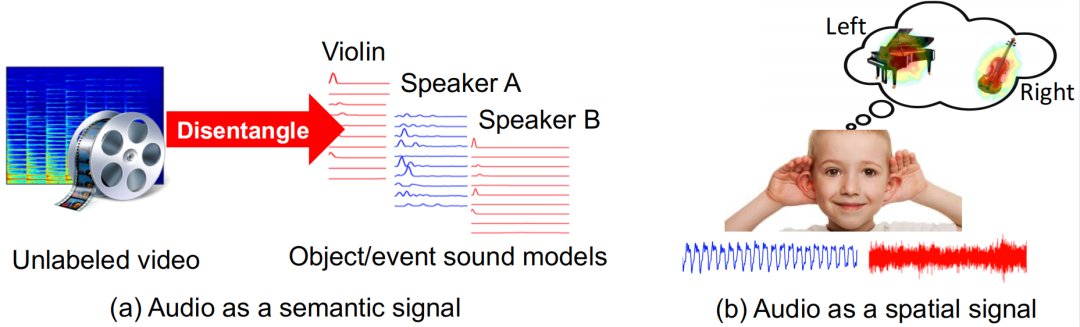

上述研究中列举了高博士对声音空间信息的一些研究,而高博士的博士论文中除了研究声音的空间信息,还重点研究了声音的语义信息,探讨了如何同时利用声音和视觉更好地辅助学习视觉任务。那么如何理解声音的语义信息呢?

文章插图

这种思路可以联系到认知科学里面的“鸡尾酒会效应”,“我们在参加一个鸡尾酒宴会的时候,环境可能会很嘈杂,但是我们的注意力会很容易集中在与你进行谈话的那个人身上。同样,如果两个人在谈话,他们的声音可能是混在一起的,但如果通过结合人脸的视觉信息,就可以更好地将声音分离出来。”

- 攻克|打破日本垄断!售价7亿元的设备被中企攻克,已开始量产

- 图灵奖|中国科技团队创历史,360打破行业垄断,登顶世界最强人工智能榜

- 工业机器人|打破韩国OLED屏垄断,中国从进口变成出口,国产有望冲击全球第一

- 联想|打破记录!数字人民币(试点版)App登上应用商店排行榜

- Windows11|8天50分!打破无人机无加油最长续航记录,未来将应用于反潜

- mybatis|支付“国家队”诞生!用户已超1.4亿,微信和支付宝的垄断被打破

- 显卡|千元机很酸爽,iQOO Z3越级打破“固有印象”

- jvm|打破多年外资垄断,新国货用2年时间在天猫成赛道第一

- 抢推8款国产旗舰机,谁能打破“iPhone神话”

- 抢推8款国产旗舰机,谁能打破“iPhone神话”?