源1.0|源1.0开源开放,AI大模型再也不是“头部玩家”的奢侈品( 二 )

纳德拉说:“在未来,无论是10年还是20年,我们有希望将大规模模型的数学原理与符号逻辑推理相结合并取得突破。下一代的模型架构又会是什么样?或者说深度学习在过去20年或10年取得了巨大进展,那么下一个大事件会是什么?我认为我们正处在突破的边缘,这(大模型)会是一个值得我们继续推进的绝佳领域。”

文章插图

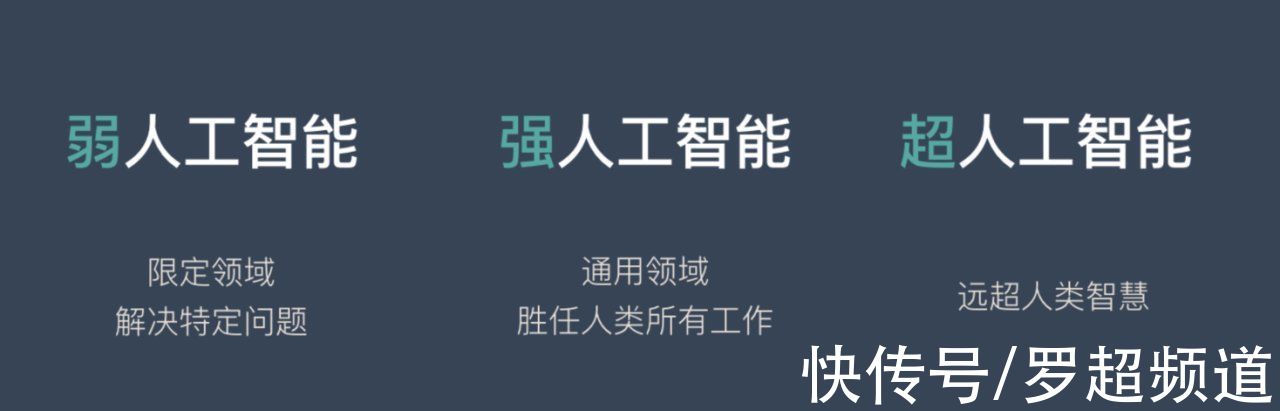

谷歌用AlphaGo将深度学习技术引入公众事业,推动AI进入黄金发展阶段,接着又用BERT将AI世界带入到大模型时代。AI大模型的价值已被众多科技巨头跟深度学习相提并论,各路巨头在AI大模型的竞赛中,推动着强人工智能时代的到来。

AI大模型不应成为巨头游戏AI大模型风风火火,然而现在却成了巨头们的游戏。

深度学习理论上人人都可参与研发探索,然而,具有“巨量数据、巨量算法、 巨量算力”三大特征的AI大模型却成了门槛很高的技术竞赛。对于任何企业包括巨头来说,打造一个大模型都不是一件容易的事情,需要收集海量数据、需要采买海量算力、需要进行大量研发,金钱、时间、人力投入同样“巨量”,正是因为此构建AI大模型的企业几乎都是财力雄厚、技术强悍的巨头——微软甚至宣称其用了价值10亿美元的超级计算机来训练其AI大模型。在“土豪”的科技巨头外,少数有一定科研经费和实力的机构推出了小众的大模型,但不具备工业化条件。

AI大模型出现的原因正是因为AI工业化的需要,泛化通用等技术优势正是为AI产业化的海量应用场景而生,如何才能让AI大模型成为所有AI开发者(技术服务商、企业组织、智算中心)可以用到的AI能力?唯一的答案在于开源开放。

AI大模型就应该是开源开放的。其本质是大模型算法模型的集中化或者说中心化,如同“云”一样,将巨量数据、巨量算法、巨量算力整合到一个地方实现,再给不同场景提供通用底层预训练能力。然而,现在各路巨头都在投入资源建设自己的AI大模型,PK参数规模或数据集大小,争夺各类榜单位置,形成一个个割裂的AI大模型资源烟囱,却忽视了AI大模型诞生的初心。

文章插图

在人工智能计算大会AICC2021上,浪潮宣布了“源1.0”的开放开源计划,据浪潮人工智能研究院首席科学家吴韶华介绍,源1.0第一阶段将面向三类伙伴(高校和科研机构的AI方向团队、浪潮合作伙伴以及智能计算中心)从数据、API到代码全面开源开放,并一起推动源1.0在国产芯片上应用。

虽然微软等巨头明确表示要将AI大模型打造成“可帮助其他人构建平台和技术解决方案”的AI平台,然而现在从底层彻底开源开放的AI大模型却凤毛麟角,虽然开发者可以申请试用部分AI大模型可以,然而申请门槛高、排队时间久、训练时间长,距离可满足工业应用的“开放”很远。源1.0要做的则是类似于谷歌TensorFlow一样的开源开放,后者是深度学习开发者的首选开源框架之一。源1.0想要成为行业都能用的AI大模型,做AI算法基础设施。

文章插图

那么,什么样的AI大模型适合开放开源?

首先,要有足够强的技术性能。

任何平台开源开放要得到开发者拥护,前提都是平台本身要有足够强的技术优势,这样对开发者才有实质价值,也才有吸引力,AI大模型的开放同样不例外。

源1.0有底气建立开源开放生态在于技术的底气:单论参数规模其拥有2457亿参数,超过1750亿参数的GPT-3,且其解决了巨量模型训练不稳定的业界难题,提出了稳定训练巨量模型的算法。

- 供冷供热约占全球终端能源消耗的50%|吸附式制冷材料研究取得进展

- 运营商|手机六连靓号被运营商回收,拒绝补贴20万,运营商:浪费资源

- 化州市富美家电维修店整合行业招商运营资源的专业平台

- it|浪潮宣布加入 OpenCloudOS 操作系统开源社区

- 本文来源于微信公众号有趣青年(ID:v_danshen)“一分钟聊‘青年理想城市’”互动...|“我不敢在微信上表白。”

- 锐龙|为什么AMD只推出一款锐龙7 5800X3D?因为资源都优先给Milan-X了

- 蔚来发布Aspen 3.1.0更新 强化蓝牙链接功能/增加动态透明底盘

- 昌江区珠山区区县服务商整合行业招商运营资源的专业平台

- 买斗整合行业招商运营资源的专业平台

- 来源:楚天交通广播、微博、中新经纬版权归原作者所有|热搜第一,微信上线新功能!