NLP|不拆分单词也可以做NLP,哈工大最新模型在多项任务中打败BERT( 二 )

文章插图

结果,WordBERT-ZH在四项任务中都打败了所有其他对比模型,在全部五项任务上的表现都优于基线BERT,并在TNEWS(分类)、OCNLI(推理)和CSL(关键字识别)任务上取得了3分以上的差距。

这说明,基于词的模型对中文也是非常有效的。

最后,实验还发现:

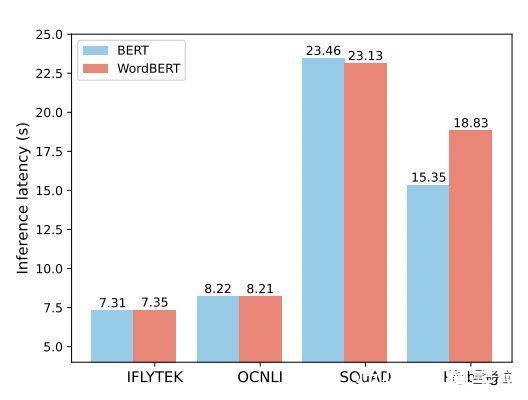

性能不差的WordBERT,在不同任务上的推理速度也并未“落于下风”。

文章插图

关于作者一作为哈工大计算机专业在读博士生冯掌印,研究方向为NLP、文本生成。

文章插图

他曾在微软亚研院自然语言计算组、哈工大和科大讯飞联合实验室实习,在NLP领域的顶会ENNLP发表过一篇一作论文。

通讯作者为史树明,来自腾讯AI Lab。

文章插图

论文地址:

https://arxiv.org/abs/2202.12142

— 完 —

量子位 QbitAI · 头条号签约

- 咖啡店|在星巴克、瑞幸、Manner打工:不像咖啡师,更像“机器人”?

- 平台|唯品会们,不讲GMV故事了?

- 苹果|苹果要坐不住了,欧盟态度强硬,华为、小米等国产手机才是榜样

- 中国制造罕见比不过印度?被非洲市场嫌弃,国产农机该反省了!

- 高通骁龙|骁龙8跑分不敌天玑9000,销量遭遇滑铁卢,高通何以至此?

- 苹果|苹果iPhone7 Plus出现卡顿,先不要急着换,三波操作后,再战三年

- OPPO|OPPO不再低配高价,价格不超1500元,这三款手机最值得考虑

- 小屏|喜欢小屏的人不得不爱,四款旗舰随心选,各方面都很出色

- 机器|一款不错的掌上游戏机:GKDmini

- 短视频|挑战TikTok,海外市场也逃不过短视频真香