麻省理工学院|当AI学会高数:解题、出题、评分样样都行( 三 )

面板A中对微积分方程问题的主题背景进行了补充,将其重新表述为一个编程任务的问题。补充背景包括澄清含糊不清的定义和运算符,或有一个以上标准用法的符号,说明学生通过学习课程就会知道的隐含假设,包括课程的主题或课题,指出学生从与问题相关的讲座或教科书章节中学到的适当方法。 面板B中使用了Python库、sympy库和streamplot库的背景,用于解题和绘制可视化图。如果程序的语法与Python版本不兼容,或者数据类型有错误,又或者没有使用库,合成程序在执行中可能无法得到正确的答案。 面板C中显示了概率和统计学中的一个例子,原始问题被转化为生成模拟的概率编程任务。在做题时学生可以从课程的主题和涵盖的材料中得到一些信息,在这个过程中,要通过了解问题背景,确定所需要的是什么类型的答案,对处理形式有一个合理预期。例如,概率或组合学中的许多问题可能需要用阶乘、组合函数或指数来回答。因此在实验中也必须要提供背景,以便用正确的方法来处理问题。 面板D考虑到NLP模型在处理长而复杂的文本方面有困难,因此将较长的问题分解成了具体的编程任务,并删除了多余的信息。通过互动产生了多个图,交互式使用Codex可以使可视化图很好地被绘制出来,并且可以发现缺失的功能或需要的库。 面板E来自《计算机科学数学》,对问题进行了简化处理,简化包括删除多余的信息,将长的句子结构分解成较小的组成部分,并将提示转换为编程格式。概括提炼出简洁的提示和一系列较短的问题,可以提高Codex性能。

原样提示。原始问题和Codex 提示是相同的; 自动提示转换。原始问题和Codex提示不同,Codex提示是由其本身自动生成的; 手动提示转换。原始问题和Codex提示不同,Codex提示是由人生成的。

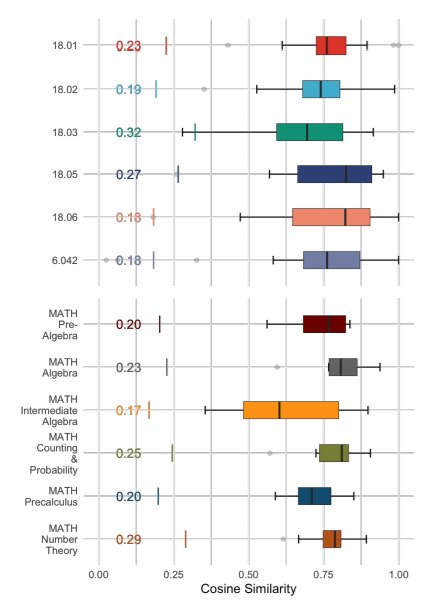

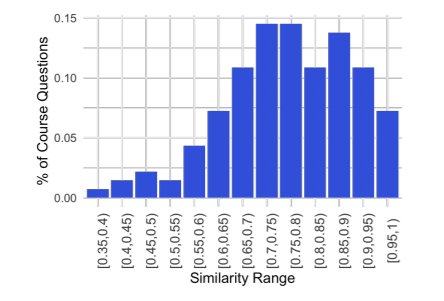

文章插图

文章插图

- 发现最小白矮星,其大小相当于月亮,这让科学家很兴奋

- 任正非|假如美团外卖关闭了,对当今社会来说是利大于弊?还是弊大于利?

- 自动驾驶|华为首秀自动驾驶,王兴:特斯拉遇到技术与忽悠能力相当的对手了

- 腾讯|投出公司的总市值顶两个科创板,腾讯在给哪些企业当“后台”?

- 努比亚|16+512G存储,突然降了1500!有50倍变焦+5nm处理器,当真值得

- 马化腾|反垄断当前,小马哥见机行事:鹅厂只是一家普通公司,随时被取代

- 联想|司马南没告诉你们,当年联想的使命根本不是研发,而是赚钱养计算所

- 交汇点讯 近日|创新担当!紫金山实验室获两项全国级科技大奖

- 抖音|海外抖音版当下网红17岁美少女粉丝过亿,年收高过美国顶尖CEO

- 显卡|宿舍出600张“女生自用”3080显卡 网友:显卡当护垫?