文章插图

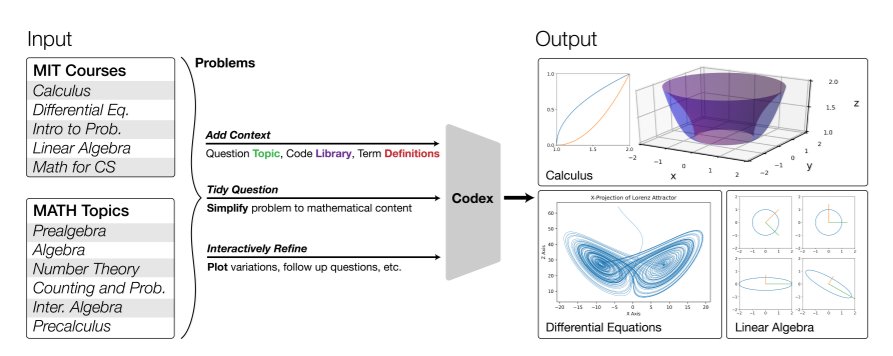

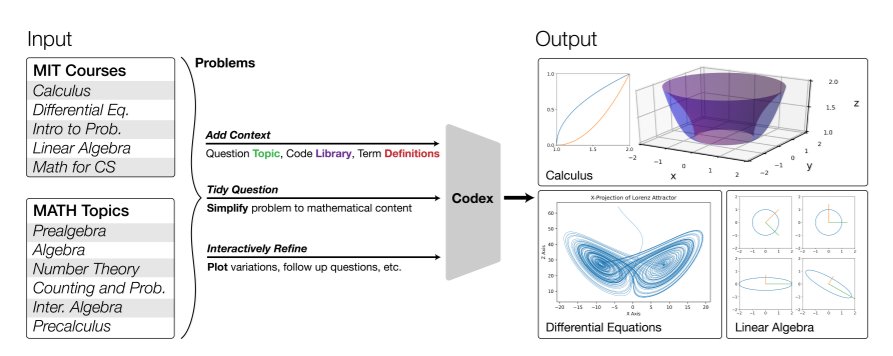

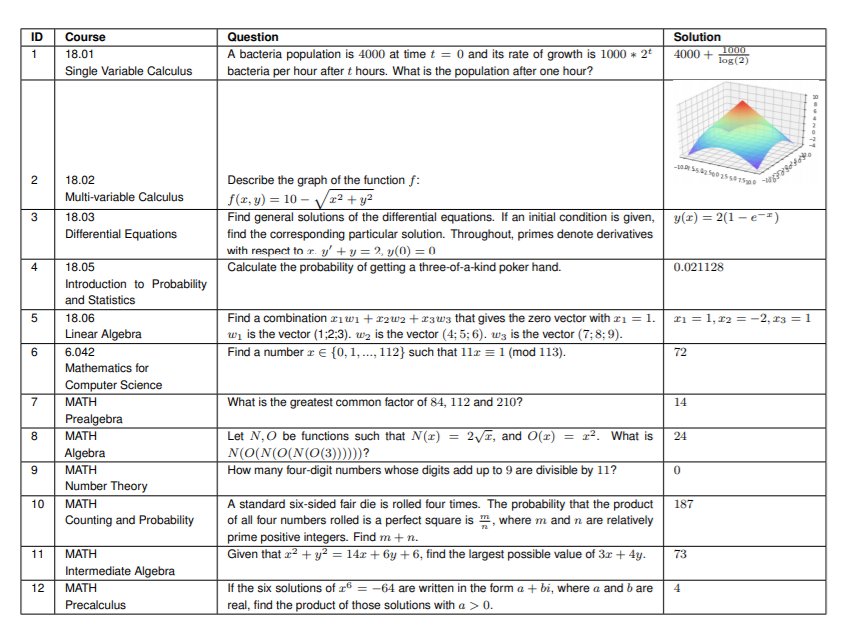

图1:图中展示了模型可求解的高数问题。例如,在微积分18.01-02中,求由两个二维图形限定的二维区域围绕z轴旋转一周得到的体积(右上);在微分方程18.03中,求解洛伦兹奇异吸引子(右下);在线性代数18.06中,画出奇异值分解(SVD)的几何图形(右下)。“以前使用Transformers解决数学课程问题的工作之所以失败,是由于像GPT-3一样的Transformers,只在文本上进行了预训练。”研究团队认为此前工作使用验证或预测表达式树的联合训练输出,虽然在解决小学水平的数学问题(如MAWPS和Math23k)时,准确率超过80%。然而,这种方法的有效性并未在高中、数学奥林匹克或大学水平的数学课程中得到扩展。后来有人通过与图神经网络(GNN)配对预测算术表达式树(expression trees),并在文本上预训练Transformers,来求解大学水平问题,且准确率高达95%。但是这个结果仅限于数字答案,并局限于特定课程,不容易扩展到其他课程。而本文的这项研究证明,把问题变成编程任务进行程序合成,是大规模解决数学和STEM课程的关键。“对文本进行预训练并对代码进行微调的 Transformers ,可以在MATH数据集和大学水平的数学课程上取得完美表现。”如图1所示,研究团队将麻省理工学院课程中的数学问题和MATH数据集进行处理,并将其作为输入传给OpenAI Codex Transformers,使要解决的问题转化为编程任务,然后执行自动生成程序。问题不同,运行程序的输出形式也不同,包含数字输出形式,甚至可以通过程序合成从文本中产生图片输出形式。该团队用prompt生成法(prompt generation methods ),使Transformers能够为每个随机抽到的问题生成带图的解题程序和方案。相比之下,这项工作可以输出包括图表在内的多种模式,并且不需要专门的训练就可以扩展到其他数学课程。他们还对原始问题和转化后的问题进行了对比量化,并通过调查评估了生成问题的质量和难度。

文章插图

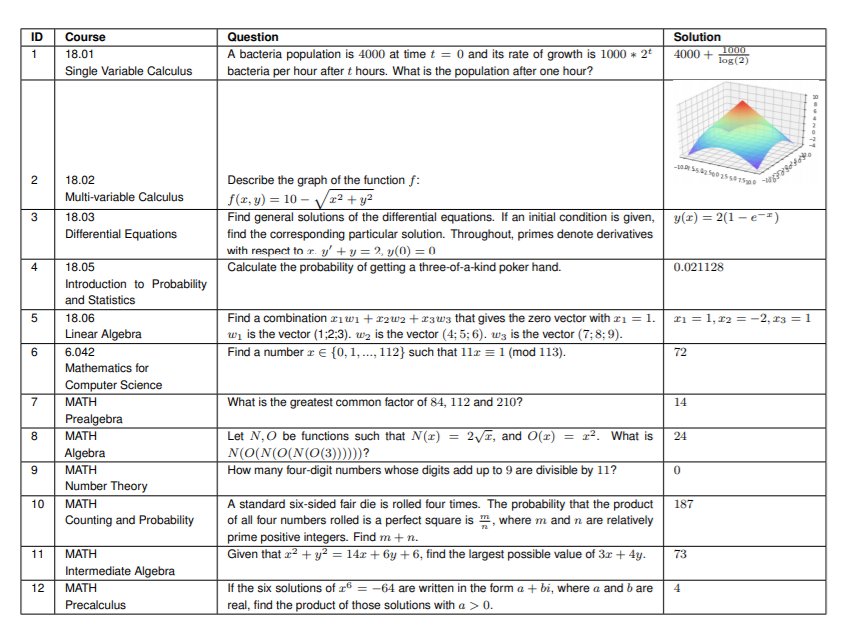

表1:针对六门课程(18.01, 18.02, 18.03, 18.05, 18.06, 6.042)和MATH数据集的六个主题(预-代数,代数,中级代数,计数和概率,预-微积分,数论)中的一些问题的解决方案。解决方案可包含数字答案、方程式和图表等。在上表所列的麻省理工学院的数学课程中,使用该方法可以很好地自动解决、评分和生成问题,并且所有这些都是实时的,每个问题处理时间竟不到一秒。研究实验题目来自麻省理工学院六门课程中随机抽取的25个问题,和MATH数据集的六个主题中各随机抽取5个问题。并且,为了说明他们的研究结果不是过度拟合训练数据,他们还用了在训练期间网上查不到的新的应用线性代数课程COMS3251来进行验证。技术代替人进行解题时,并不是使用技术对问题进行重大修改,而是努力提取问题的本质,因此,该团队使用Codex对问题进行了整理。

文章插图

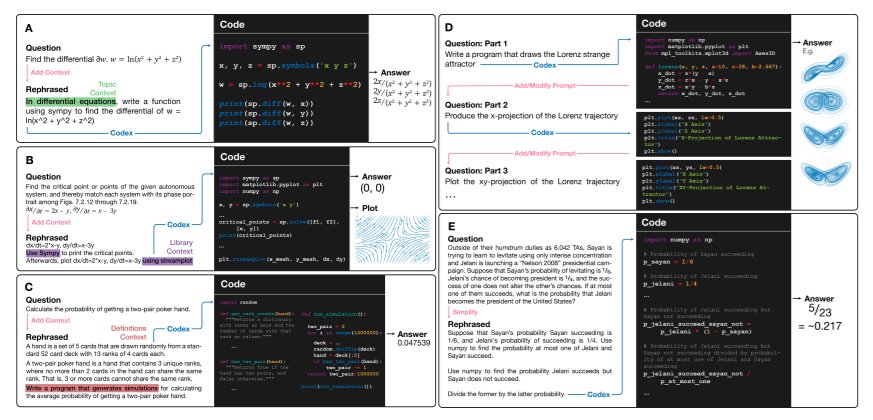

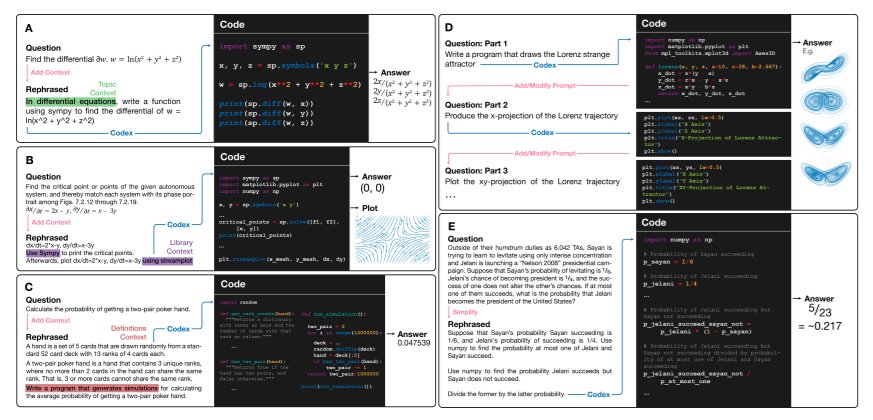

上图中,显示了使用Codex将课程问题转化为编程任务并运行程序以解决数学问题的方法。每个面板的左半部分显示了原始问题和通过添加问题背景、互动或简化后而重新表述的问题。