可加性|普林斯顿大学王梦迪:从基础理论到通用算法,看见更大的AI世界观( 三 )

「我现在回想起来,他从来没有说过一句令我沮丧的话。如果我处在他的位置,可能对『我』会有挺多意见的。」

在Bertsekas的门下,王梦迪更多是学习到了一种高级的研究品味。这是一种与大咖导师同行、耳濡目染之下培养的研究思路。

【 可加性|普林斯顿大学王梦迪:从基础理论到通用算法,看见更大的AI世界观】Bertsekas在应用数学与系统控制方向均有极高的研究造诣,著有《概率导论》、《非线性规划》、《随机优化控制》与《强化学习与最优控制》等十多本著作与教材,是名副其实的大咖。在他的反复锤炼下,王梦迪慢慢明白一项好的研究工作应当具备怎样的标准,「他是一点一点地把我拎到了那个高度。」

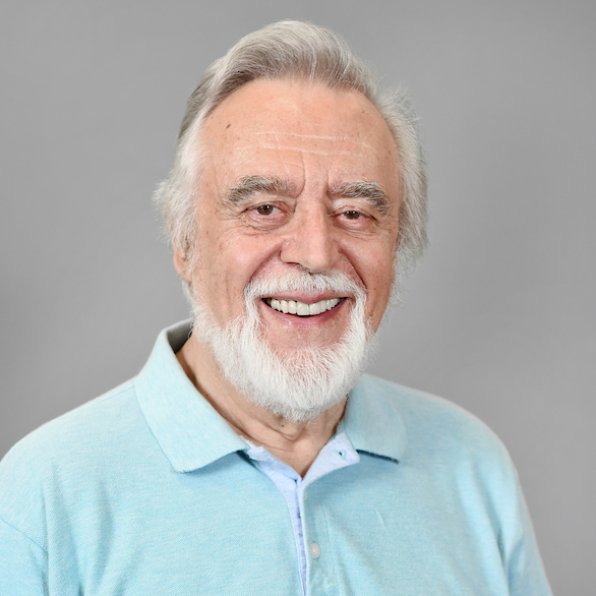

文章插图

图 / Dimitri P. Bertsekas

Bertsekas是2019年完成《强化学习与最优控制》一书,彼时,王梦迪已离开导师的庇荫许久,在强化学习这一她自己独立拓展的领域打开一片新的天地,成为了人工智能、强化学习领域能够独当一面的学者。

对控制论与强化学习的关系思考,也使王梦迪相信:学习效率更高、泛用性更强的算法,是人工智能的未来。

3、机器学习与强化学习理论探索

王梦迪在2014年开始进入普林斯顿担任助理教授,2019年成为普林斯顿大学的终身教授,之后王梦迪加入了普林斯顿当时刚成立不久的统计与机器学习中心(Center for Statistics and Machine Learning,CSML),是最早加入CSML的教授之一。

CSML的主要研究内容是开发数据驱动的现代机器学习算法,与王梦迪的研究方向更契合。同样是举下棋的例子:就下棋而言,智能体的训练数据来自于游戏本身,每尝试新的玩法、就会收集到新的数据;在一个可以完美模拟的游戏环境中,智能体所收集的数据量甚至是无上限的。如何从模拟走向现实,即「sim2real」,是人工智能领域面临的难题之一。

自2015年DeepMind开发的Alpha Go 在与世界围棋冠军李世石的对峙中取胜,强化学习便成为许多人工智能研究员的神往之地,王梦迪也是其中之一。

文章插图

图 / 普林斯顿大学统计与机器学习中心(CSML)

在早期工作中,王梦迪是将数学优化方法与高维统计相结合,以解决大规模机器学习中的图问题。比如,当图问题离散组合时,如何利用问题的特殊结构,将问题进行对偶分解,从而获得一个出色的近似解。这一近似解借用了非凸优化的对偶性,与非凸问题的最优解相近。

她探索过复杂的多层期望嵌套的随机规划问题。通过巧妙的设计多层嵌套随机梯度法,能够在线的进行迭代,最终拿到的估计的统计效果与离线进行完整组合分析的效果一致。凭借这项研究,王梦迪在2016年获得三年颁发一次的国际数学规划学会青年学者奖(Young Researcher Prize in Continuous Optimization of the Mathematical Optimization Society)。

这些探索性的研究更加深了王梦迪对随机优化理论与机器学习结合的兴趣。接着,她又与斯坦福大学的叶荫宇(冯诺伊曼理论奖唯一华人获得者)等人合作,研究马尔可夫决策链(MDP)的理论复杂度与最优算法。

MDP是强化学习的基础模型,同时,MDP的算法复杂度也是运筹学领域的经典问题。他们要解决的问题是:当强化学习的样本来自于马尔可夫链时,要如何研究一个算法的最优收敛性与样本复杂度?如何定义MDP问题的最优算法与计算复杂度?从上世纪70年代起,便有许多学者开始研究这些问题,但一直悬而未决。

- 小米科技|不聊性能只谈拍照!新旗舰反向升级成潮流,拍照手机如何选?

- 小米科技|预算只有两三千买这三款,颜值性能卓越,没有超高预算的用户看看

- 苹果|最具性价比的苹果手机来了,降价2120元,iPhone12已跌至冰点价

- 小米科技|RTX3060的性能到底如何?相比RTX2060提升有多大?

- 将理论注入深度学习,对过渡金属表面进行可解释的化学反应性预测

- OPPO|OPPO A97曝光:5700mAh大电池加持,性价比十足

- 苹果|手机性能排行:华为垫底,vivo第一,黑马不是小米

- |盘点三款外观颜值最适合春节的手机:一款比一款好看,性价比很高

- 小米12|自研动态性能调度!小姐姐实测小米12 Pro《王者荣耀》:功耗下降20%

- CPU|电脑硬件选购技巧之CPU散热,性价比干货,土豪回避