可加性|普林斯顿大学王梦迪:从基础理论到通用算法,看见更大的AI世界观( 二 )

同样地,强化学习也是基于系统的状态,不断对系统进行动态操控。区别在于,对于强化学习算法来说,待控制的系统是一个黑箱函数,不具备完整的数学描述,难以直接求解最优策略。所以,强化学习有潜力解决很多复杂但模糊的新问题,比如游戏的最佳策略,蛋白质的设计等等。

本科期间,王梦迪便是从控制论出发,首次接触了强化学习算法。

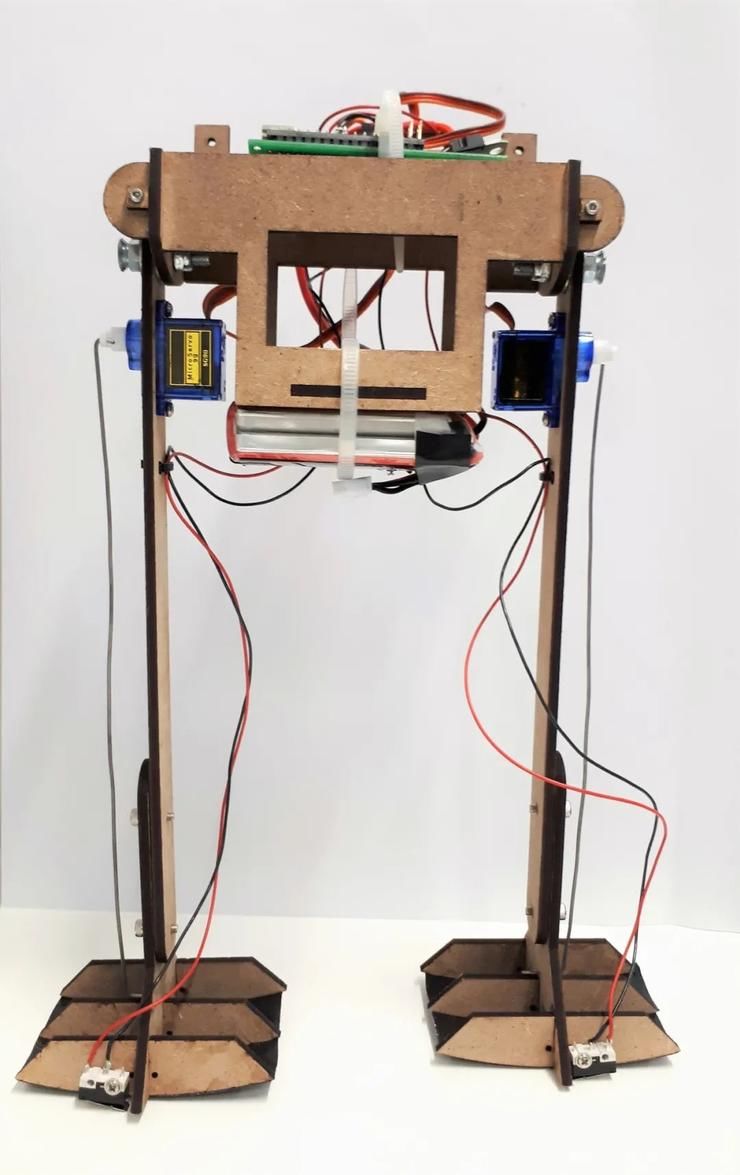

清华自动化系的本科毕业设计要做一个双足行走的机器人,在机器人的髋关节中间加一个小小的电机,目标是用最小的能量让机器人流畅地行走起来。假设机器腿是完美的刚体结构,腿部的摆动可以用拉格朗日方程精确描述。这时,经典的控制论就可以找到最优的控制策略。

文章插图

图 / 双足机器人(图源网络)

然而现实的场景往往不符合假设,不存在精确的数学描述。课题中,要先不施加电机输入,观察机器人在斜坡如何利用重力和摆动被动走起来;走起来后,收集它的行走轨迹数据。然后,再基于数据,探索如何通过控制髋关节的电机,设计一个自适应的反馈系统,让机器人摆脱对重力的依赖、在平地上健步如飞。

面对这样一个动态过程,强化学习被派上用场:如果把双足机器人系统当成一个黑箱函数,基于价值函数和策略函数不断迭代、更新、实验、逼近,就能通过不断的试验进行在线学习,算出一个最适合双足行走机器人的状态-价值函数,找到最优控制策略。

文章插图

图 / 王梦迪在 2017 年中国人工智能大会上作演讲,谈控制论与人工智能的关系

随着控制问题的复杂度不断提升,控制算法对系统建模的依赖也需逐渐放松,注重通过实验来收集数据、从数据中总结模型信息、在线学习来逼近最优系统操控策略的强化学习方法将在复杂系统中扮演越来越重要的角色。从这一点来看,控制论成就了人工智能的核心,而强化学习等新兴方法又反哺了控制问题的求索:

「比如,下棋本身无法用微分方程来描述,但我们可以一边下、一边收集下棋和对手的信息。当我们对要控制的系统的先验知识越来越少时,我们就越来越依赖于来自经验与数据的近似,并利用大规模深度神经网络进行高通量的计算、拟合和推理。」王梦迪介绍。

基于反馈、优化、乃至于深度学习,现代人工智能早已改变了人类的生活和认知,从自动驾驶到机器人流水线,从宏观电网调度到微观的蛋白质优化。控制论中的许多经典思想和方法,比如贝尔曼方程、模拟、反馈、系统辨识等方法,深刻影响了以深度强化学习为代表的现代人工智能研究上。

2、MIT读博:科研观的形成

在MIT读博期间(2007-2013),王梦迪师从 Dimitri P.Bertsekas教授,隶属于信息与决策系统实验室(Laboratory for Information and Decision Systems, LIDS),主攻控制算法与随机优化问题。

MIT 的 LIDS 实验室的研究传承来自于维纳与香农。维纳是控制论之父,而香农是信息论之父,控制论和信息论,分别代表了工业自动化时代和信息时代的开端。自成立以来,LIDS实验室的杰出科学家们便追求将控制论与信息论结合起来,用于复杂系统的智能化和信息化。

王梦迪的博士导师、美国国家工程院院士 Dimitri P.Bertsekas 是自动控制领域的宗师,于控制论、优化、运筹、神经网络等多个领域做出过奠基性贡献。

王梦迪对AI科技评论回忆,读博那会,导师Bertsekas非常宽松。王梦迪是他的关门弟子,他一直很鼓励她的发散性思考,从不否定她的各种脑洞大开的想法,这让王梦迪进一步释放了在清华时就开始积淀的对开创性的新问题、新领域的追求:

- 小米科技|不聊性能只谈拍照!新旗舰反向升级成潮流,拍照手机如何选?

- 小米科技|预算只有两三千买这三款,颜值性能卓越,没有超高预算的用户看看

- 苹果|最具性价比的苹果手机来了,降价2120元,iPhone12已跌至冰点价

- 小米科技|RTX3060的性能到底如何?相比RTX2060提升有多大?

- 将理论注入深度学习,对过渡金属表面进行可解释的化学反应性预测

- OPPO|OPPO A97曝光:5700mAh大电池加持,性价比十足

- 苹果|手机性能排行:华为垫底,vivo第一,黑马不是小米

- |盘点三款外观颜值最适合春节的手机:一款比一款好看,性价比很高

- 小米12|自研动态性能调度!小姐姐实测小米12 Pro《王者荣耀》:功耗下降20%

- CPU|电脑硬件选购技巧之CPU散热,性价比干货,土豪回避