威力|颜水成发了个“简单到尴尬”的模型证明Transformer威力源自架构( 二 )

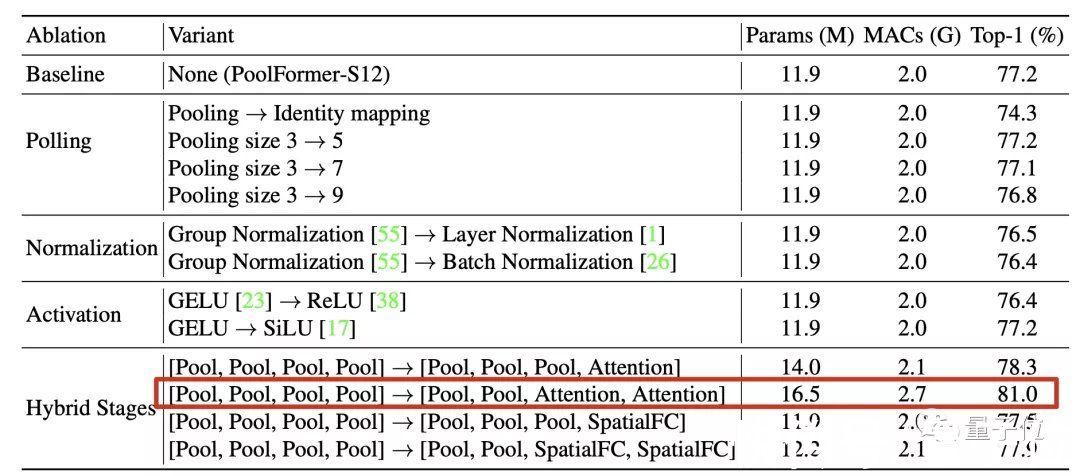

到底是整体架构重要?还是说PoolFormer中的池化模块刚好是一种简单却有效的Token Mixer?

团队的验证方法是把池化模块直接替换成恒等映射(Identity Mapping)。

结果令人惊讶,替换后在ImageNet-1K上也保留了74.3%的Top-1精度。

在此基础上无论是改变池化核尺寸、归一化方法、激活函数影响都不大。

最重要的是,在4个阶段中把注意力和空间全连接层等机制混合起来用性能影响也不大。

其中特别观察到,前两阶段用池化后两阶段用注意力这种组合表现突出。

这样的配置下稍微增加一下规模精度就可达到81%,作为对比的ResMLP-B24模型达到相同性能需要7倍的参数规模和8.5倍的累计乘加操作。

文章插图

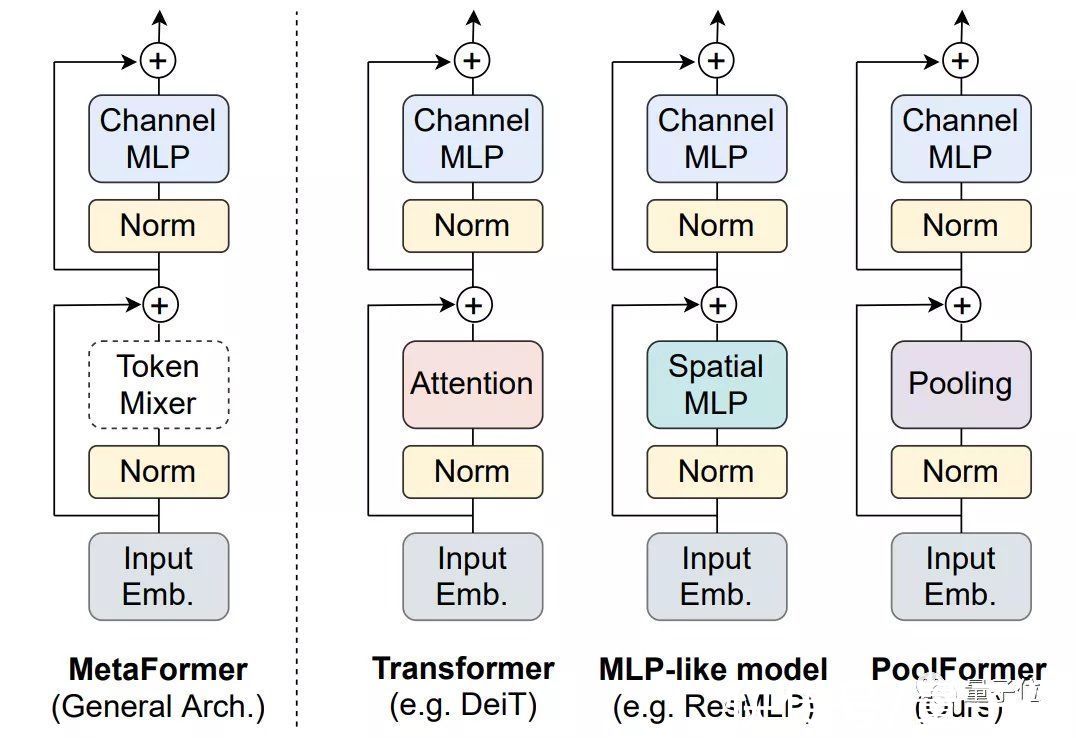

最终,消融实验结果说明Transformer中具体到token mixer这个部分,具体用了哪种方法并不关键。

不增加模型规模的情况下,网络的整体结构才是对性能提升最重要的。

这样的整体结构被团队提炼出来,命名为MetaFormer。

文章插图

NLP上还会成立吗?这项研究由颜水成领导的Sea AI Lab和来自新加坡国立大学的成员共同完成。

文章插图

△颜水成

论文的最后,团队表示下一步研究方向是在更多场景下继续验证,如自监督学习和迁移学习。

除了视觉任务,也要看看在NLP任务上结论是否也成立。

另外发这篇论文还有一个目的:

呼吁大家把研究的重点放在优化模型的基础结构,而不是在具体模块上花太多精力去打磨。

文章插图

论文地址:

https://arxiv.org/abs/2111.11418

GitHub仓库:

https://github.com/sail-sg/poolformer

— 完 —

量子位 QbitAI · 头条号签约

- 小米科技|预算只有两三千买这三款,颜值性能卓越,没有超高预算的用户看看

- |盘点三款外观颜值最适合春节的手机:一款比一款好看,性价比很高

- 海尔|燃魂时刻,高颜值也有好手感,又为颜值买了单!

- 小米科技|三月份发布,小米12 Ultra颜值回归,神似Mate40

- 旗舰机|21年最值得入手的四款手机 颜值高+性能强 旗舰机千元机各占两款

- 人才|俄罗斯00后“天才情侣”加入华为,高颜值高智商情侣,网友慕了

- OPPO|直角边框高颜值,拥有出色手感的OPPO A96将于明日开售

- iqoo|颜值高配置强,年底换机小米12、iQOO 9值得入手

- 华为matebook d|英特尔赛扬G6900展现新架构威力,超频后单核性能与酷睿i9-10900K相当

- 读特客户端?深圳新闻网2022年1月14日讯(记者 罗瑜 实习生 韦秋颜 )1月6日|易星标技术荣获集成电路领域“创芯新锐奖”