用户|从中国到美国,为什么我们需要禁用算法的权利

近年来,早前萦绕在互联网企业身上的光环已经开始逐渐褪色,并且随之而来的,是各国监管机构将其放到了聚光灯之下。就在不久前,国内监管部门连续发布《互联网信息服务算法推荐管理规定(征求意见稿)》与《关于加强互联网信息服务算法综合治理的指导意见》后,海外市场也开始关注互联网企业使用算法所造成的影响了。

文章插图

日前有消息显示,美国众议院议员提出了一项法案,要求Meta旗下的Facebook和Google等互联网平台允许用户查看非算法选择的内容,也就是要求这些平台向用户显示算法之外的信息。这些议员在声明中表示,“消费者应该有权选择如何使用互联网平台,而不必受到由特定用户数据驱动的秘密算法操纵。”

【 用户|从中国到美国,为什么我们需要禁用算法的权利】当大洋两岸都开始关注互联网企业用算法来改变乃至塑造潮流的能力,无疑是一种好事。毕竟,算法如今已成为了互联网世界中几乎是最为核心的信息推送机制,并成为了大家日常生活中不可分割的一部分,甚至算法机制在某种意义上已经塑造我们的社会意识。

文章插图

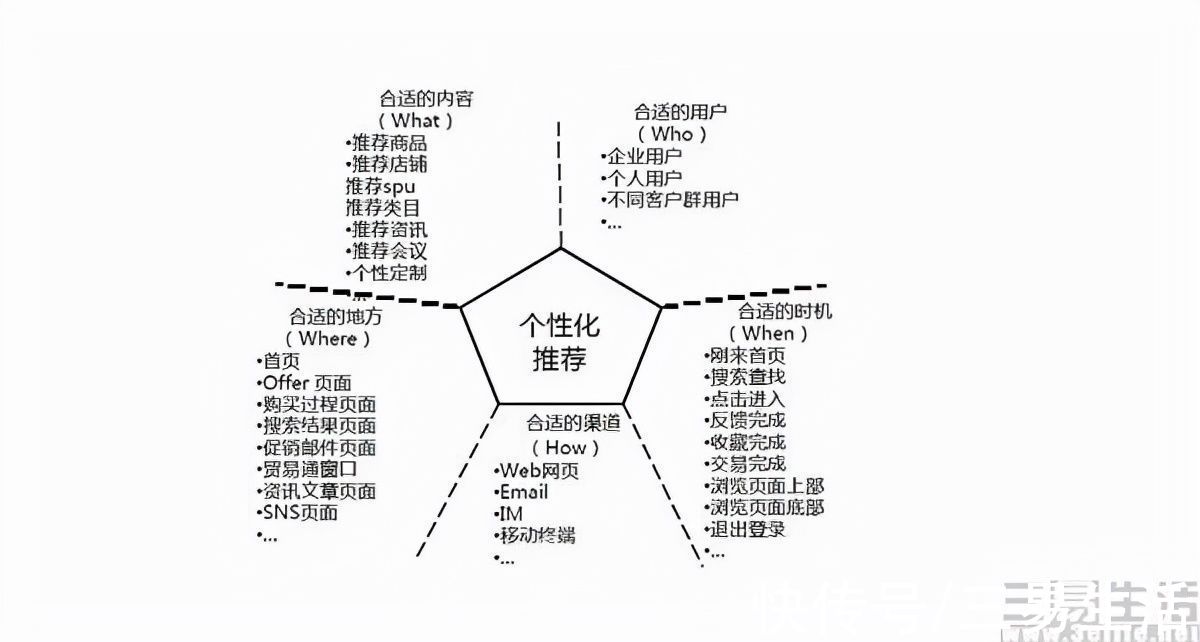

通常,我们所说的“算法”指的是推荐算法,本质上其实是一种信息过滤的手段。早期,互联网厂商秉承着原教旨的互联网精神,将所有信息一股脑地推给用户,但用户却并没有接收海量信息的能力,所以即便是搜索引擎也需要用户先有一个“关键词”。但问题是互联网上的信息太多,而人的认知范围太小,这就导致了在算法出现前,大量有价值的信息被浪费,并没有被真正需要的人发现。

这时候推荐算法帮助用户解决了信息过载的问题,是一种信息发现工具。对于互联网厂商来说,推荐算法实现了挖掘用户需求并投其所好的作用,它的引入是以内容推送代替了用户的寻找,其设计初衷是增加用户寻找目标内容的效率。而讨好了用户、满足了用户需求,也就意味着互联网厂商的商业利益得到了保证。

文章插图

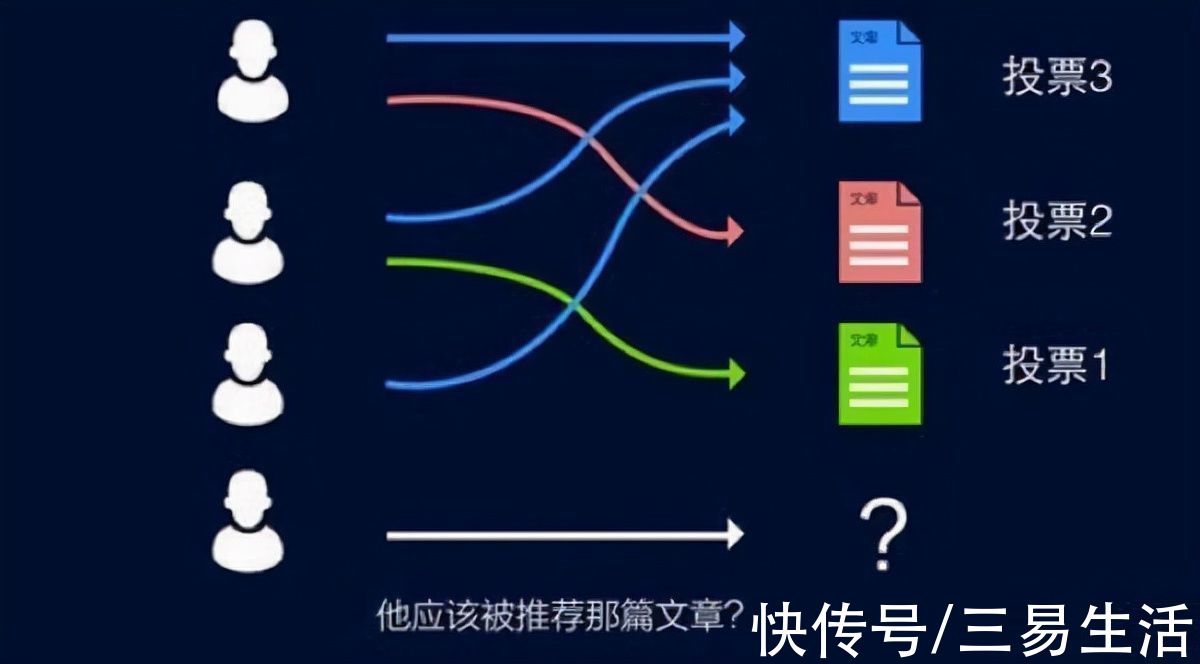

那么为什么推荐算法走到今天,却反过来被不少用户反感,甚至于需要被监管呢?一种通俗的解释,是推荐算法会让用户陷入“信息茧房”或“过滤气泡”(Filter Bubble)。因为算法会基于用户的个人兴趣、社交关系、地理位置等数据,推荐与用户偏好高度匹配的个性化内容,但长期处于单一信息来源的环境下则会形成回音室效应,将自己桎梏于像蚕茧一般的“信息茧房”中,容易一叶障目不见泰山。

不过在学界关于"算法是否会将用户囚禁在信息茧房中”的问题,其实是有一定争议的。传播学中的“选择性接触理论”揭示了这样一个事实,就是人通常更倾向于接触与自己既有立场、观点、态度一致或接近的媒介和内容,而有意无意地去回避那些与自己既有倾向相左的媒介或内容。从这一理论出发,就可以解释为什么人们更愿意向与自己价值观、立场、态度等相似的人靠近,以此获得抱团取暖、相互支持的可能,并最终形成一个个小圈子的原因。

文章插图

换句话来说,基于兴趣或价值观进行信息消费其实是人的天性,陷入“信息茧房”也是某种从人性出发的必然,所以算法并不是“罪魁祸首”。而推荐算法真正的问题,其实在于伦理和道德领域,以及它在互联网时代重新建构了人与社会的关系。

事实上,推荐算法是在以机器学习为代表的第三次人工智能浪潮兴起的背景下出现,机器学习算法通过基于大数据的自我训练、自我学习过程,完成参数调整与模型构建,并实现自我强化。英国物理化学家、哲学家迈克尔·波兰尼曾指出,“人类知道的远比其能表达出来的更多”,这就是经典的“波兰尼悖论”。

- 产业|打造世界级产业地标 中国声谷冲刺5000亿产值

- 三星|试图挽回中国市场,国际大厂不断调价,从高端机皇跌到传统旗舰价

- 小米科技|预算只有两三千买这三款,颜值性能卓越,没有超高预算的用户看看

- 蓝思科技|苹果与34家中国供应商断绝合作,央视呼吁:尽快摆脱对苹果依赖

- 他是“中国氢弹之父”,他的名字曾绝密28年,他叫于敏

- 短信|关于5G消息,中国移动取得新进展,微信该做准备了

- 一个时代的结束!中国移动:10086 App将于1月30日起

- 苹果|从5499元跌至3399元,苹果A14+IP68防水,旧款iPhone加速清仓

- 小米科技|从4999跌至2889元,2K曲面屏+IP68防水,小米老款旗舰售价大跳水

- 骁龙855|从3499元跌至1190元,5000mAh+骁龙855,适合玩游戏