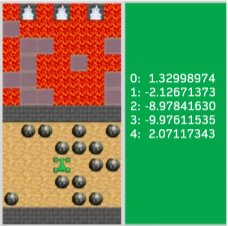

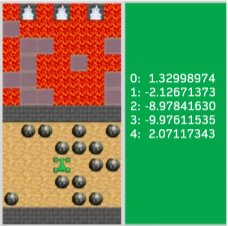

在这项研究中,作者调查了两个不同的群体——有人工智能背景和没有人工智能背景的人,他们如何看待不同类型的人工智能解释。以下是用户对AI生成的三种解释的看法: 在这项研究中,参与者观看了三个智能体在连续决策环境中的导航视频,并提供了定性和定量的感知信息——在一个满是滚动的巨石和流动的熔岩的环境中,为被困的探险者取回必须供应的食物。智能体通过简单地输出当前状态的数字Q值执行 "思考"过程(如图1)。Q值代表智能体对每个行动的信任程度(不包含 "为什么"可信),参与者事前没有被告知这些Q值的意义,所以他们不知道哪些数值对应哪些行动。

文章插图

实验发现,两类参与者都对数字盲目信任,但信任的程度和原因不同。作者采用"认知启发"的概念,试图理解背后的原因。他们发现,对于有人工智能背景的参与者来说,仅仅是出现的数字就能引发启发式思考。他们不完全理解智能体决策背后的逻辑,但也会将数学表示法与逻辑算法的思维过程联系起来。有意思的是,他们还把最聪明的AI投给了“行为最奇怪”的智能体,这说明,他们不仅过度重视数字结果,而且将“含义不明”的数字视为潜在的可操作性。这里的"可操作性"指的是在判断或预测未来行为方面,人们可以用这些信息做什么。那么,智能体在实际场景中的可操作性到底如何?正如之前所强调的,Q值不能表明决策背后的 "原因"。除了评估现有行动的质量,这些数字并没有太多可操作性。也就是说,参与者对智能体产生了过度信任和错位评估。对于没有人工智能背景的参与者来说,即使无法理解复杂的数字也会引发启发式推理,在他们看来,智能体就一定是智能的,这些数字代表了智能体“神秘而不可理解”的独特语言。需要说明的是,这种推理方式与之前有人工智能背景的人的推理过程不同,他们假设了未来的可操作性(尽管目前缺乏可理解性)。如我们所看到的,没有标记的、无法理解的数字反而增加了两类群体对智能体的信任和评估。这项案例研究表明,即使没有欺骗的意图,EPs也会出现未曾预料到的结果,并误导参与者对数字生成过度依赖。需要强调的是,本次案例假设Q值的“本意”是好的,如果这些数字被操纵了,一些人利用这些隐患恶意设计黑暗模式,鉴于案例中用户对数字的启发式信任,这将会误导更多人对系统产生过度信任和不正确认知。总结来看,可解释性陷阱(EPs)有两个特性,一是它仅是存在,但并不一定会对下游产生危害;二是现有知识不能预测给定的一个人工智能解释何时、如何以及为何会引发意料之外的负面下游效应。基于以上两点,作者认为虽然我们不太可能完全消除解释的负面效应,但需要意识到“陷阱”的存在,了解它们何时容易出现,又是如何运作的,并制定相应的措施,做到防微杜渐。文中作者从研究、设计和组织三个相互关联的层面提出了几点策略: