量子|机器学习可有效提高超导量子比特读取效率

采访人员从中国科学技术大学获悉 , 该校郭光灿院士团队郭国平教授研究组与本源量子计算公司合作 , 在本源夸父6比特超导量子芯片上研究了串扰对量子比特状态读取的影响 , 并创新性地提出使用浅层神经网络来识别和读取量子比特的状态信息 , 从而大幅度抑制了串扰的影响 , 进一步提高了多比特读取保真度 。 该成果日前以研究长文形式发表于《应用物理评论》上 。

对量子比特状态的高保真度测量 , 是量子计算中的关键一环 。 在超导量子计算中 , 对量子比特的读取依赖于量子比特与读取谐振腔之间的色散耦合 , 通过探测读取腔的色散频移效应可以推测量子比特所处的状态 。 近些年 , 国际上分别实现了高保真度的单比特单发读取以及多比特的多路复用式单发读取 。 然而 , 由于各种形式的杂散耦合的存在 , 邻近比特的状态可能会对目标比特的测量结果产生影响 , 从而降低测量保真度 , 进而降低量子算法的成功率 。 随着量子芯片的进一步扩展 , 为了进一步提高读取保真度 , 如何解决上述串扰问题将成为研究者们面临的主要挑战 。

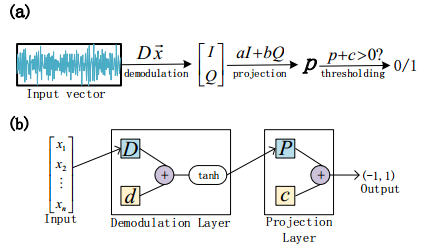

郭国平教授研究组与本源量子计算公司合作 , 通过对量子比特信息提取过程的抽象和模拟 , 提出一种新的量子比特读取方案:通过训练基于数字信号处理流程构建的浅层神经网络 , 实现对量子比特状态的精确识别与分类 。 研究人员将这一方案应用到本源夸父6比特超导量子芯片上 , 发现新的读取方案不仅有效提升了6比特的读取保真度 , 而且大幅度抑制了读取串扰效应 。

该方案不仅适用于超导量子计算 , 也同时适用于其他量子计算物理实现方案 。

文章插图

【量子|机器学习可有效提高超导量子比特读取效率】(中科大供图)

- DeepMind首席科学家:比起机器智能,我更担心人类智能造成的灾难

- 将理论注入深度学习,对过渡金属表面进行可解释的化学反应性预测

- LG电子正式加入IBM量子网络,将推动量子计算工业应用发展

- 白白胖胖头顶起雾走走停停安全无误在哈尔滨站候车厅内一边消毒一边在室内移动的智能消毒机器人...|火车站里的机器人服务,是什么体验?

- 机器人|售价10万的日本“妻子”机器人,除了生娃啥都能做?太天真了

- 人类的工作会被AI取代吗?如果机器能够深度学习|为什么说AI能作巴赫的曲,却写不出村上春树的小说?

- 王中林|华为全球专利榜第四;京东海外开设机器人零售实体店;Oculus遭反垄断调查|科技周报

- 大数据|人工智能步入千家万户,智能机器人的前景怎么样?

- 机器人|中国机器人“独角兽”,抢下国内90%份额,优势还在持续扩大!

- 机器人|老销售是怎么选电销机器人的?如何避坑?这些点需要注意