i7+|家电启示录 篇十七:我们家里的顶级机器人:iRobot扫地机器人( 三 )

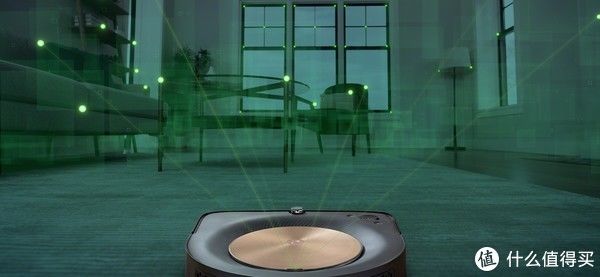

这是今年扫地机器人的主流配置,当然还加上上面的LDS来提供大范围定位,可以实现3D建模,识别物体轮廓,同时也具备距离识别能力,但是识别范围比较小,因为需要接受到发射的红外光,一般只有0.2米到1.2的识别区间。

文章插图

RGB摄像头,这就是马斯克和iRobot都想要的突破,摄像头下的真实世界的加上AI计算。

视觉导航下机器人看到的画面与人眼看到的画面无异,有人类的眼睛,AI计算的图像才会有与人类一样的思考和判断方式,行为模式才会更像人类。

三种对比哪个技术更牛,不用我说,哪怕你是小白都懂。

文章插图

其实你看iRobot的产品线,感觉就像生物的进化之路,从没有眼睛进化到了可以看见真实的3D世界,你再要他回去二维世界竞争,这是不可能的事。

所以虽然别看现在扫地机器人各种各样的感觉都还行,市场也比较火爆,但一旦iRobot这样的机器人公司在获得视觉AI突破之后,这种真实世界的视觉AI对其他种类都是降维打击的存在。

文章插图

看懂了这些,你才会理解我为什么是个iRobot粉,因为整个机器人的未来都在这样的一枚小小普通摄像头里。

视觉导航下会有很多不一样的行为,当然,在一些评测选手那里看来这是不智能的表现,但我看到的和理解的都不一样,这是高阶智慧的表现。

文章插图

比如上图这样的停顿,作为摄影爱好者我知道它是在拍全景图,要转圈一张一张的拍,拍完存下来,再做拼接。

对于机器人来说,还要记下每个关键点位的图像特征,要通过多张不同照片来计算相对位置,最后形成一个立体结构,对于LDS和TOF来说这很简单,因为扫一下就已经具备距离和位置信息了。但对视觉来说,这很难,就像我们人类看到一个物体,哪怕是看得再近也没法直接“目测”出实际尺寸和距离,这就需要大量图通位置的图像来进行精确计算了。这还不是全部,还有更多的路线规划等方面需要计算,视觉导航机器人要想的事情非常之多,几千万条代码就是这么来的。

我们知道要在电脑上做这样的大量图形处理的时候一般都会需要比较长的计算时间,放在扫地机器人上也一样,它会停顿很久,会“傻”,因为他没有像高性能台式电脑一样的性能,没有图形芯片,国内也没有可以帮助他云计算,它只能靠自己一帧一帧慢慢处理。

所以新产品新地图会有个1周左右的学习期,在建图之后仍需多次拍摄计算提取特征值,也会从每次的清扫中多次优化,哪怕是躺在充电座上的时候都在优化计算,在“想问题”,等它处理完这些之后,效率才会越来越高,也会变得越来越智能。

问题想的久,确实是傻,但问题想得多,想得全面,这是智慧的体现。

文章插图

作为iRobot的老司机,在使用半年后它走路是这样的。

以前新手期会碰桌角,会停顿思考,会这里撞撞那里撞撞,而现在直接一个流畅不带刹车的S弯零碰撞穿过了障碍物,用得越久越觉得它的环境和工作学习能力让它表现得更像人的思维模式,像有了认知力,对变化的环境也有不同的清扫行为,而非每次都只执行相同代码的死机器,这算是真的有思维的AI,能在每个细节上进行优化,而且是不断的优化。

- 家电业|为什么家电业要拒绝躺平敢于折腾?

- 化州市富美家电维修店整合行业招商运营资源的专业平台

- 苹果|华为智能家居也在找家电厂商合作,强强联手,把标准制定下来

- 巴黎协定|纳微半导体成立全球首家电动车氮化镓功率芯片设计中心

- 电子商务|农村家电市场还有多少金矿可挖?

- 华工厂|再关一家?在华工厂不赚钱,日本家电巨头干不下去?开始停工清退

- 家电业|告别冬眠与等待,今年家电业只有“主动出击”一条道

- 与海尔齐名的中国家电巨头,44亿货款收不回,只能靠“卖楼自救”

- IT影响中国评选揭晓 京东家电荣膺“年度碳中和领域影响力企业

- 电动牙刷|曾经的高端家电,如今却“跌落神坛”,10年内均价下滑了10倍不止