训练|迷你版DALL-E:模型缩小27倍,训练成本仅200美元,在线可玩!

文章插图

作者 | 维克多

自从今年1月份OpenAI祭出120亿参数魔法模型DALL·E,众多科研工作者开始对其进行多方位的剖析,希望也能做出给定“自然语言文字描述直接生成对应图片”的程序或软件。

120亿参数.........这意味着只有“顶级玩家”才能入局。如果缩小模型参数,程序还能跑出高质量的结果么?

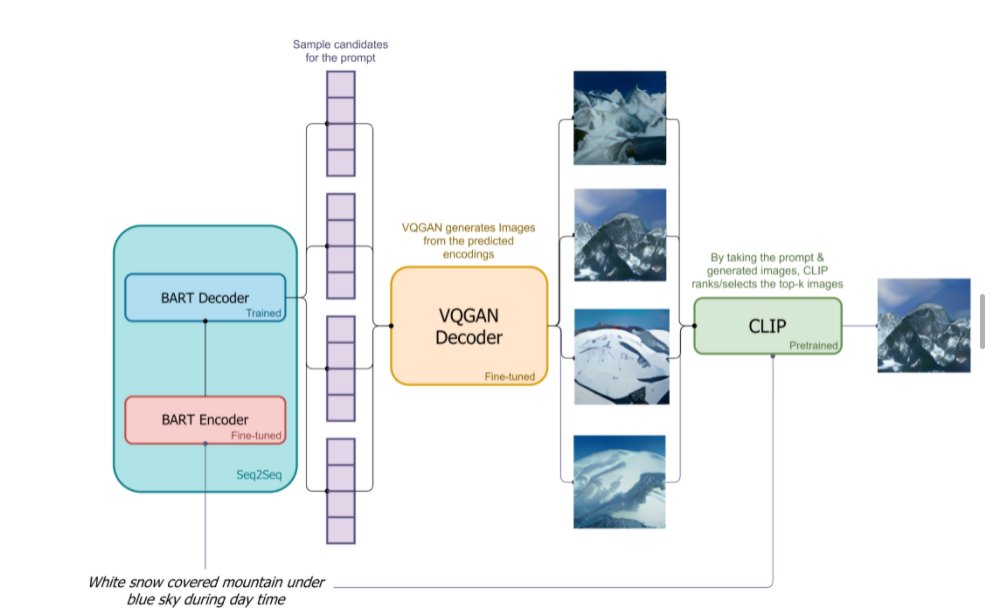

今日,谷歌和Hugging Face的研究员们开放了一款DALL·E mini的小程序。顾名思义,作为DALL·E的复刻版,模型规模比原版小了27倍,且只在单个TPU v3-8上训练了3天。

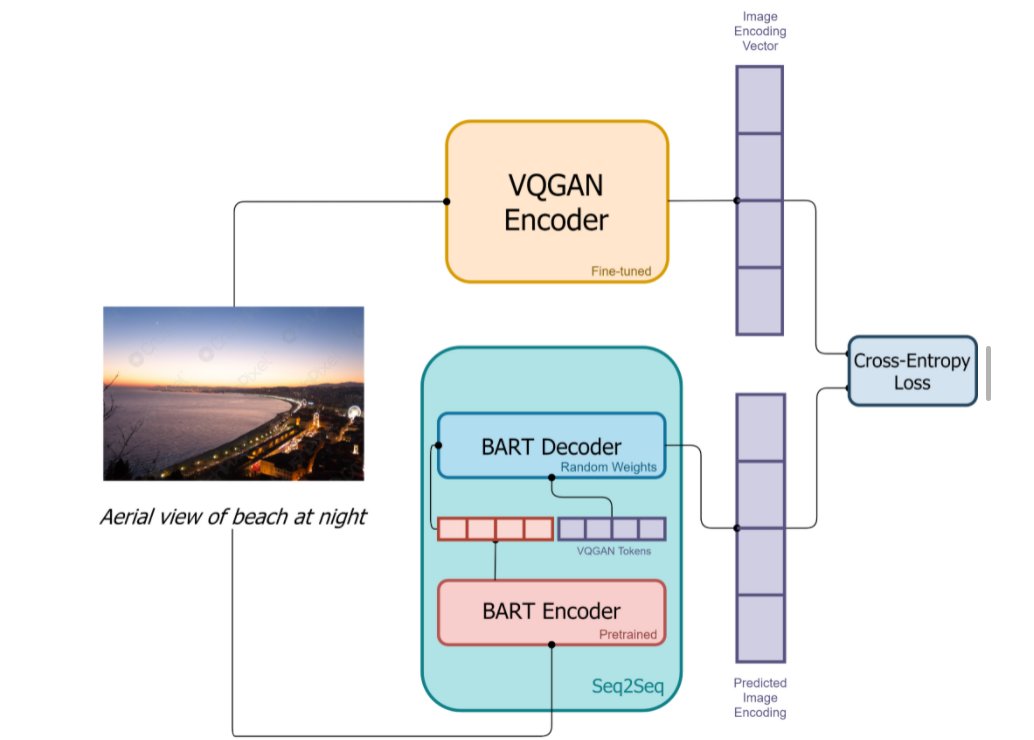

mini版的DALL·E创造思路非常简单:在官方开源代码以及预训练模型的基础上,简化体系结构和减少模型内存需求。

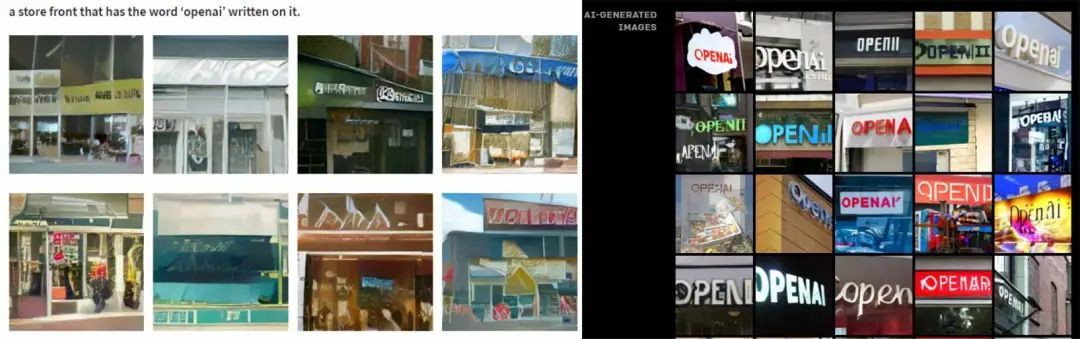

效果如何?作者在博客中说:

文章插图

文章插图

文章插图

文章插图

文章插图

文章插图

- iphone13 pro|粉丝买美版iPhone13Pro,躲过了网络锁,却没想到有配置锁!

- 华为|iOS15.2.1 正式版发布:新增 6 项改进

- 三星|三星Galaxy S22参数曝光:仍有Exynos 2200处理器版本

- iOS|苹果推送iOS15.2.1正式版修复漏洞为主 用户是否要更新看体验再说

- 军工|中国版“英伟达”诞生,核心技术完全自研,国产替代即将崛起

- Minisforum 发布 UM350 迷你 PC:搭载 R5 3550H 处理器

- 今日|《战神4》pc版正式解锁dlss和fsr性能表现

- 作为知名的迷你PC厂商|魔方推出全新amd迷你pc

- 不得不说新iMac在时尚感上的确是提升了不少|ipad简版imac花费不超300元,仅需背后的支架放下来

- 联想|百度地图、高德地图、腾讯地图的手机版,哪个导航最靠谱?