文章图片

文章图片

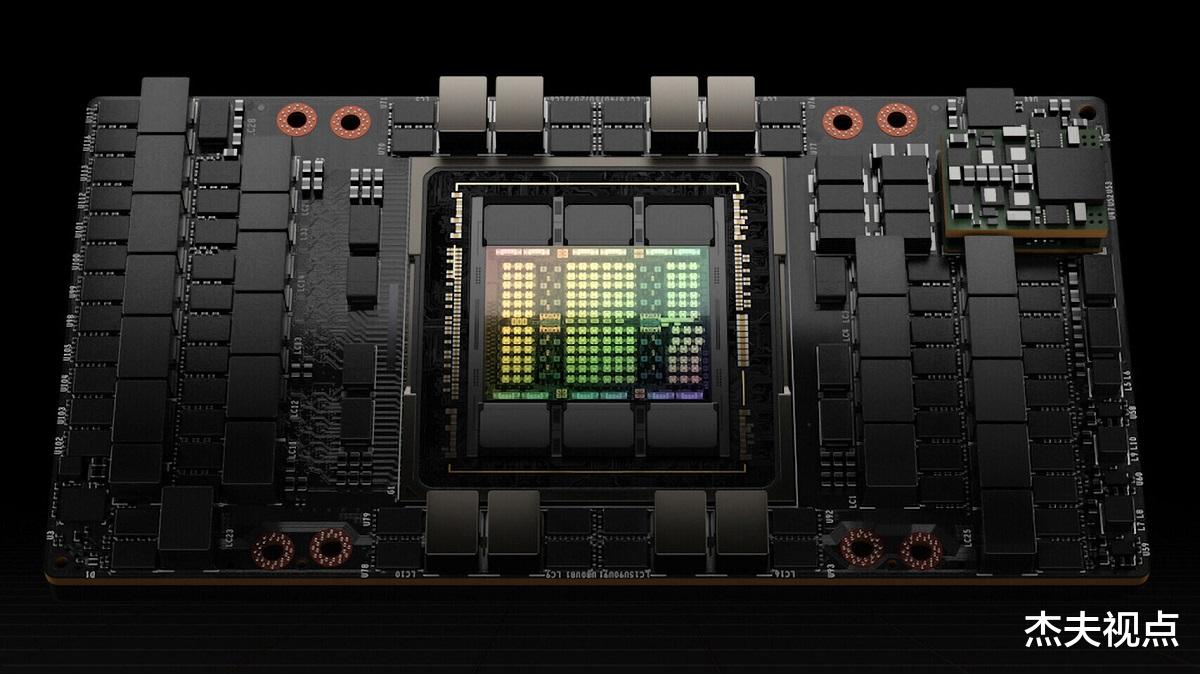

和预想的一样 , 在GTC 2022上 , NVIDIA正式发布了新一代的GPU——H100 , 这款GPU基于Hopper架构 , 专用于加速计算平台 。 简而言之 , 这颗GPU是针对超级计算机而设计的 , 它的强大主要体现在AI性能方面 , 相比上一代 , H100在架构和工艺上都已经更新换代 , 所以它的性能和效率也达到了一个前所未有的水准 。

很多人之前表示NVIDIA这次GPU无论是计算用还是游戏用 , 都会采用台积电的5nm工艺打造 , 但是H100这颗GPU显然比我们想象的芯片制程还先进 。 H100所采用的芯片工艺是台积电的N4 , 也就是4mn工艺 , 属于改进型的5nm工艺 , 但有趣的是 , 这次台积电是专门为H100单独定制了一个芯片工艺 , 和通用的N4工艺有一些区别 。

从芯片规模来看 , H100的晶体管高达800亿 , 相比上一代的A100提升了六倍性能 , 这款GPU采用单芯片设计 , CoWoS 2.5D晶圆级封装 。 NVIDIA没有公布H100的核心数量和频率 。 从之前的信息来看 , 完整的芯片应该配置了8组GPC、72组TPC、144组SM、共18432个FP32 CUDA核心 。 另外这颗GPU采用了576个第四代Tensor Core , 并配有60MB的L2缓存 , AI性能会非常夸张 , 不过不同的版本有着不同的配置 , 比如SXM5版本中启用了128组SM , 共15872个FP32 CUDA核心 , 528个Tensor Core以及50MB的L2缓存 , 功耗也达到了700W 。

如果是PCI-E 5.0的版本则会有进一步削减 , 虽然也是128组SM , 但FP32 CUDA核心则降到14952个 , 功耗也只有350W 。

H100的FP64/FP32运算性能为60 TFlops , FP16运算性能为2000 TFlops , TF32运算性能为1000 TFlops , 均是A100的三倍 。 此外Hopper架构改进了对FP8运算的支持 , 使其运算性能达到了4000 TFlops , 是A100六倍 。 不过这一架构并不支持原生FP8 , 所以NVIDIA会通过转换器引擎来自动切换FP8以及FP16的运算 。

H100采用的是NVIDIA第四代NVLink接口 , 带宽高达900 GB/s 。 如果采用PCI-E 5.0的接口 , 那么带宽则只有128GB/s 。 H100也是第一款支持PCI-E 5.0的GPU , 同时也是第一款采用HBM3的GPU , 最多支持六颗HBM3 , 带宽为3TB/s , 是A100采用HBM2E的1.5倍 , 默认显存容量为80GB 。

和过去一样 , NVIDIA会将新款的H100添加到DGX H100机架式服务器 。 每个DGX H100系统包含8块H100 , 共640GB的HBM3显存 , 可提供32 PFlops的AI计算性能 , 以及480 TFlops的FP64运算性能 。 系统中的每个GPU都通过第四代NVLink连接 , 带宽是上一代的1.5倍 , 加上全新的VNLink Swtich互连系统 , 可连接32个DGX H100节点 , 以构建下一代NVIDIA DGX SuperPOD超级计算机 。

有意思的是 , 这次NVIDIA还加入了Connect TX-7网络互连芯片 , 台积电7nm工艺 , 800亿个晶体管 , 400G GPUDirect吞吐量 , 400G加密加速 , 4.05亿/秒信息率 。 同时 , 为了扩展整个规模 , NVIDIA设计了全新的VNLink Swtich互连系统 , 可以连接最多32个节点 , 也就是256颗H100芯片 , 称之为“DGX POD” 。这么一套系统内 , 还有20.5TB HBM3内存 , 总带宽768TB/s , AI性能高达颠覆性的1EFlops(100亿亿亿次每秒) , 实现百亿亿次计算 。

【GPU|NVIDIA发布新一代GPU:4nm工艺,800亿晶体管加700W功耗】总体来看 , H100是计算用GPU的目前最高的性能水准 , 相比AMD的计算卡要强出很多 , 当然我们估计游戏的ADA架构也是Hopper架构改变精简而来 , 所以我们也可以期待未来RTX 40在性能上带给我们一些惊喜 。 至于NVIDIA这套系统 , 已经有多个合作伙伴 , 包括系统合作伙伴和云服务合作伙伴 , 会在今年第三季度开始供货 。

- NVIDIA|RTX 30显卡都在赔钱卖?据说一块亏最多1200元

- 金立|金立发布8+256G手机,加入华为HMS后热度更高,仅售899元

- 宾得k|理光欣然发布墨黑色限量版K-3 MarkIII相机

- 运动相机|Insta360影石发布ONE RS多镜头运动相机 4800万像素

- 哈苏|国产骁龙8哈苏影像旗舰!一加10 Pro海外发布定档:3月31日见

- 电子商务|你的PC电源要换了:Intel发布ATX 3.0规范,显卡供电达600W

- 一加|一加即将发布首款平板电脑:已投产、预计上半年公布

- 英特尔|NVIDIA要和Intel合作?老黄确认谈判,未来GPU或让Intel代工

- NVIDIA|RTX 3090 Ti新卡皇功耗450W!附送450W转接电源线

- 高通骁龙|冲破引力,黑鲨5系列发布会定档3月30日