nerf|买不起手办就用AI渲染一个!用网上随便搜的图就能合成( 二 )

训练时,深度提取网络需要跑6~13小时,渲染网络则跑2~4小时。

用网络图片就能渲染3D模型至于训练NeROIC采用的数据集,则主要有三部分:

来源于互联网(部分商品来源于网购平台,即亚马逊和淘宝)、NeRD、以及作者自己拍摄的(牛奶、电视、模型)图像,平均每个物体收集40张照片。

那么,这样的模型效果究竟如何呢?

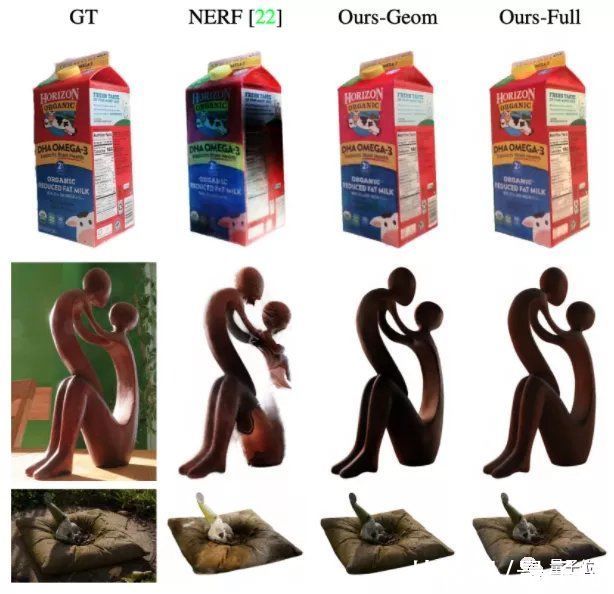

论文先是将NeROIC与NeRF进行了对比。

从直观效果来看,无论是物体渲染细节还是清晰度,NeROIC都要比NeRF更好。

文章插图

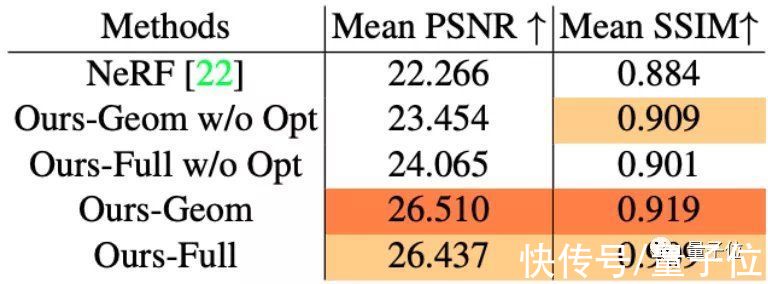

具体到峰值信噪比(PSNR)和结构相似性(SSIM)来看,深度提取网络的“抠图”技术都挺不错,相较NeRF做得更好:

文章插图

同时,论文也在更多场景中测试了渲染模型的效果,事实证明不会出现伪影等情况:

文章插图

还能产生新角度,而且重新打光的效果也不错,例如这是在室外场景:

文章插图

室内场景的打光又是另一种效果:

文章插图

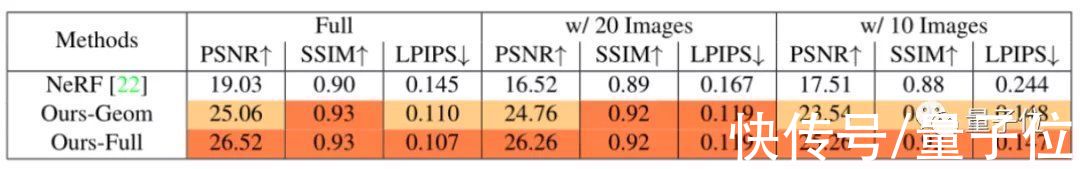

作者们还尝试将照片数量减少到20张甚至10张,对NeRF和NeROIC进行训练。

结果显示,即使是数据集不足的情况下,NeROIC的效果依旧比NeRF更好。

文章插图

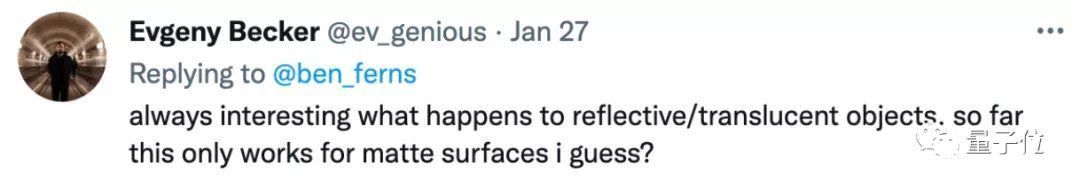

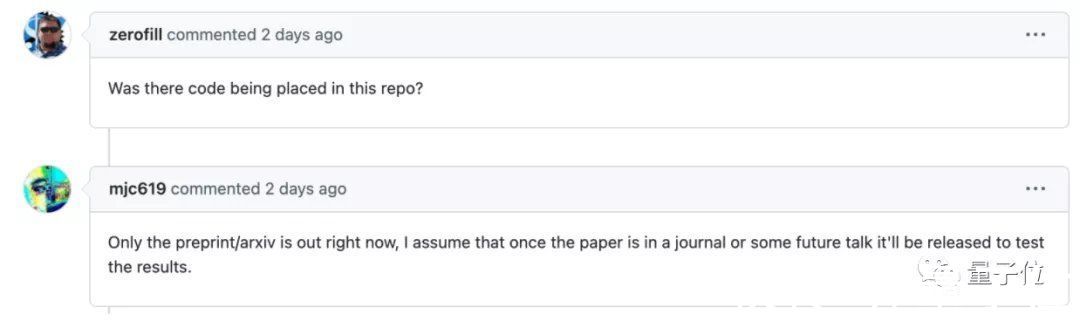

不过也有网友表示,作者没给出玻璃或是半透明材质的渲染效果:

文章插图

对AI来说,重建透明或半透明物体确实也确实是比较复杂的任务,可以等代码出来后尝试一下效果。

据作者表示,代码目前还在准备中。网友调侃:“可能中顶会、或者在演讲之后就会放出”。

文章插图

一作清华校友

文章插图

论文一作匡正非,目前在南加州大学(University of Southern California)读博,导师是计算机图形学领域知名华人教授黎颢。

他本科毕业于清华计算机系,曾经在胡事民教授的计图团队中担任助理研究员。

这篇文章是他在Snap公司实习期间做出来的,其余作者全部来自Snap团队。

文章插图

以后或许只需要几张网友“卖家秀”,就真能在家搞VR云试用了。

文章插图

论文地址:

https://arxiv.org/abs/2201.02533

项目地址:

https://formyfamily.github.io/NeROIC/

参考链接:

[1]https://zhengfeikuang.com/

[2]https://ningding97.github.io/fewnerd/

[3]https://twitter.com/ben_ferns/status/1486705623186112520

[4]https://twitter.com/ak92501/status/1480353151748386824

— 完 —

【 nerf|买不起手办就用AI渲染一个!用网上随便搜的图就能合成】量子位 QbitAI · 头条号签约

- ttoc|精彩冬奥·携手办赛|冬奥通信保障“智慧大脑”这样运转

- CPU|买不起新机,老机也不错!6.4英寸屏+骁龙888,其实不算老

- 显卡|其实,等等党也不是买不起显卡,主要是心理接受不了溢价

- Python|搭载4扬声器的红米K50,让我连红米都买不起了

- 本文转自:巍巍上郡风一平安榆林萌宠可爱的“顶流”网红冰墩墩旋转手办2月8日起在榆林开启预...|榆林已开启预售,你的“冰墩墩”来啦!

- 社交|官方点名美团为骑手办理社保——骑手的权益谁来保护?

- 北京冬奥组委|对话冰墩墩生产厂商:已全面复工,手办或率先恢复供应

- 小米科技|降价后还是买不起!骁龙888 +2K四曲面屏,小米传统的高端机!

- 买不起说说还不行吗?春节聊聊索尼,希望我明年可以轻松拿下

- 冬奥会|北京冬奥会吉祥物冰墩墩手办爆火!奥林匹克官方店卖光了