明敏 发自 凹非寺

量子位 | 公众号 QbitAI

现在,丢给AI一张图,它不仅能看图说话,还能应对人们提出的刁钻问题了。

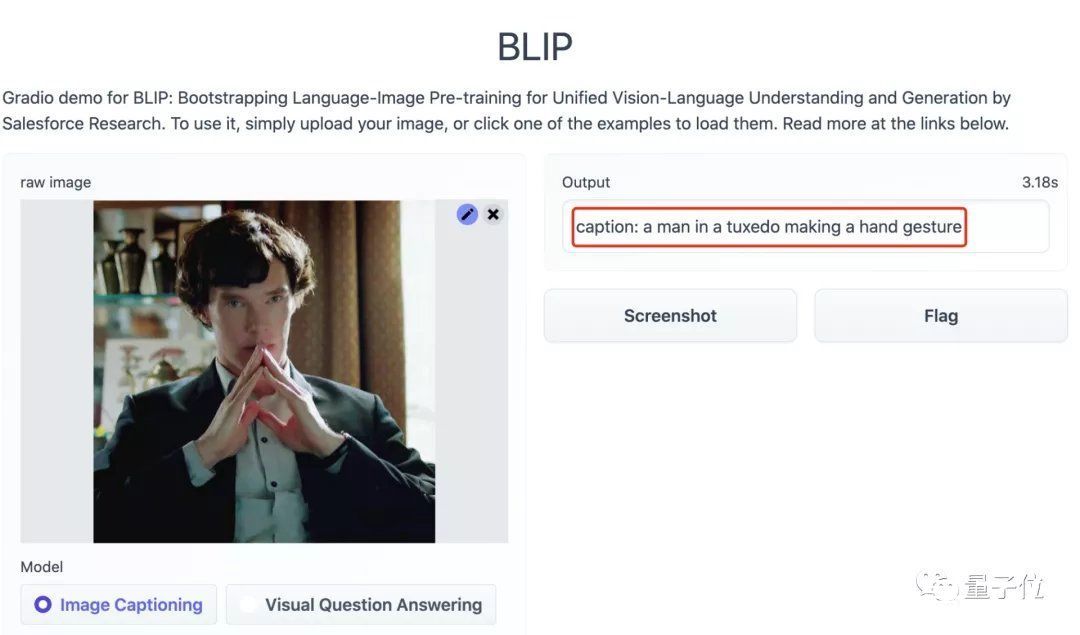

比如,给它看一张经典卷福照。

文章插图

它便能回答出:

一个穿着西服、正在比划手势的男人。

那么图中男人的眼睛是什么颜色的呢?

蓝色。

文章插图

我定睛一看,还真是如此!

这就是视觉-语言领域的新成果:BLIP (Bootstrapping Language-Image Pre-training)。

它突破性地将过去往往只能单独执行的视觉-文本生成、视觉-文本理解两种任务整合在了一起,让AI可以在看图说话和视觉问答两种模式来回切换。

并且在各种任务上的表现也都优于过去SOTA方法,VQA准确率超过78%,逼近人类基准线(80.83%)。

话不多说,就让我们来试玩一下,看看这个模型究竟有多厉害。

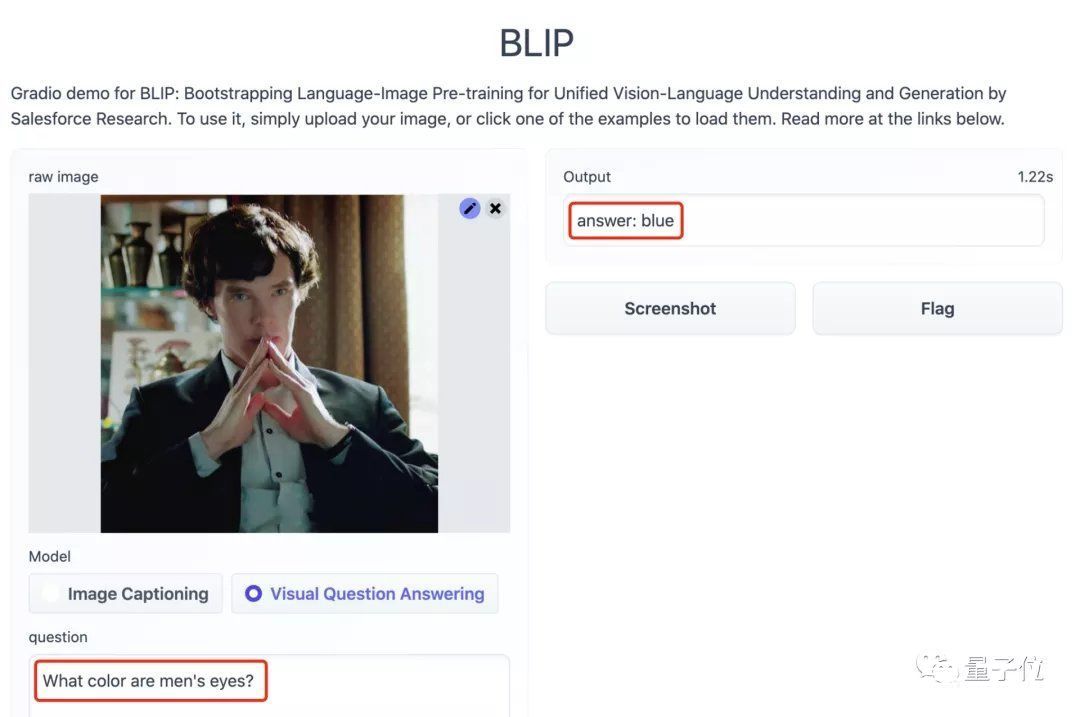

Demo试玩BLIP可以提供两种功能。

第一是描述图片的内容,第二是回答有关图片的提问。

上传好图片后,便可从图片下方的模式中任选一种进行试玩。

文章插图

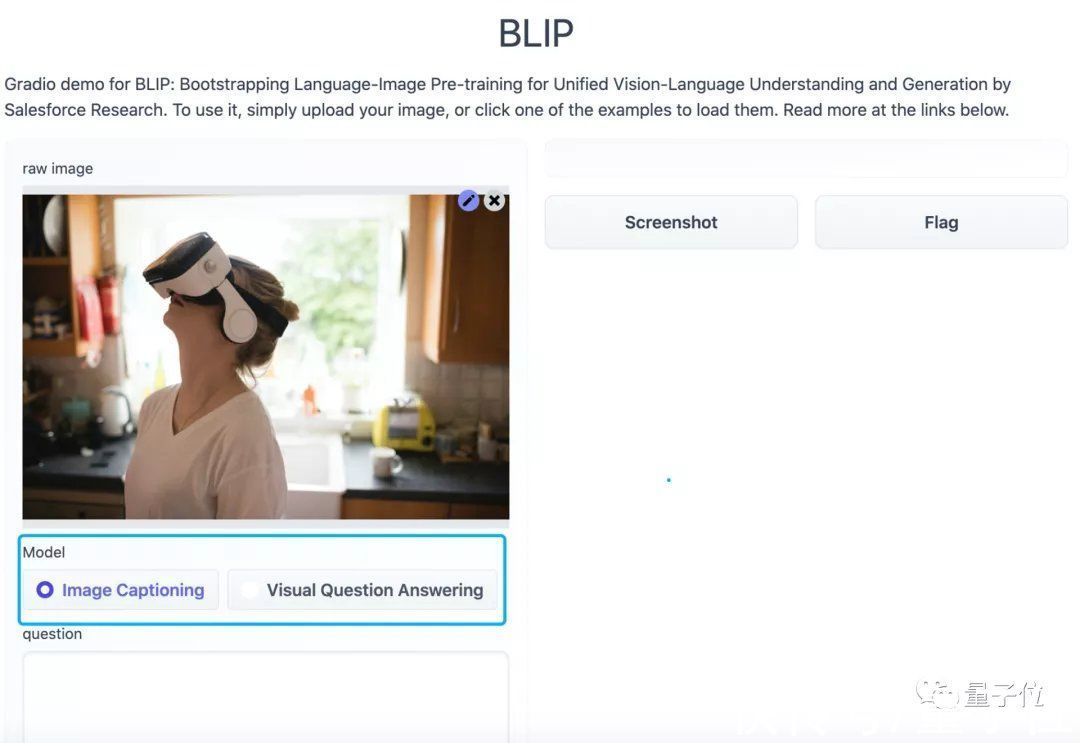

首先我们来看看它看图说话的水平如何。

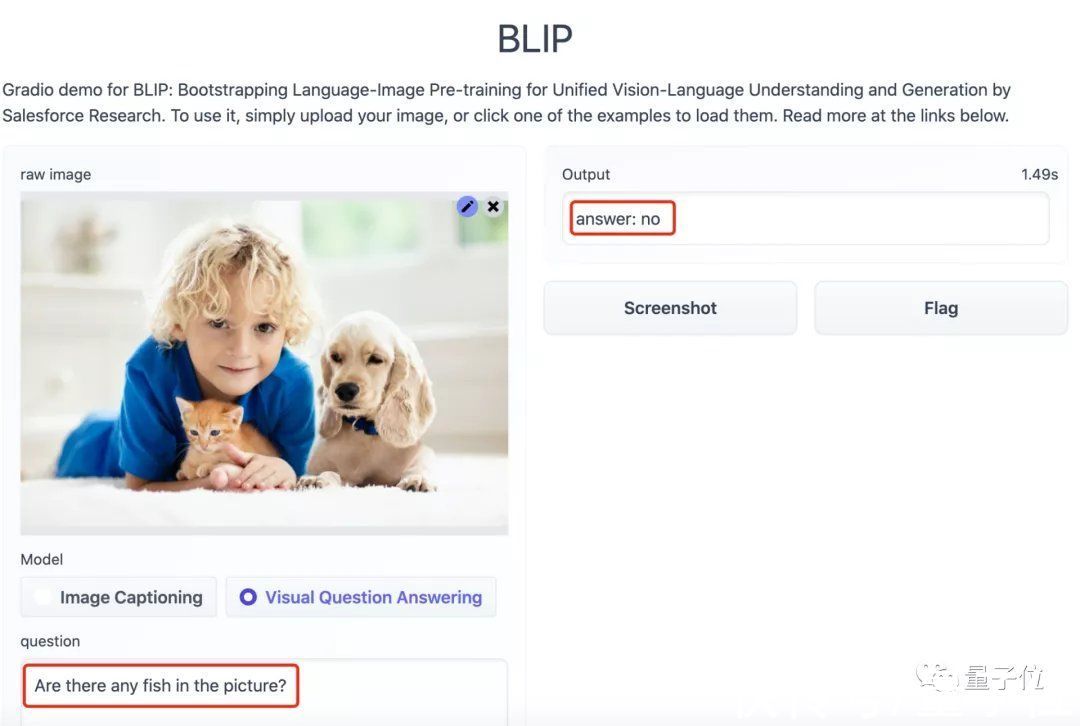

上传了一张有小孩、猫、狗多种元素的图片后,模型输出的内容为:

一个小男孩和一只猫、一只狗一起趴在地上。

文章插图

再提问试试看:

图中有鱼吗?

BLIP:NO.

文章插图

可以看到,BLIP对图片的理解很到位,那么再多换几张图片呢?

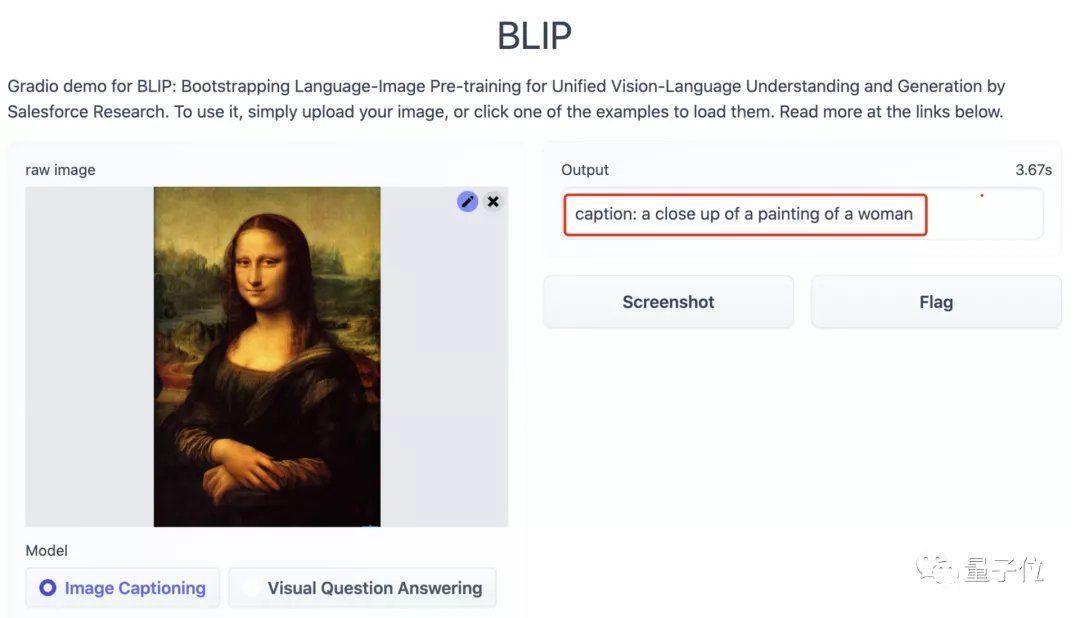

当我们上传蒙娜丽莎的画像后,模型很轻松地辨别出来了这是一张女人的画像,并非是一张照片。

文章插图

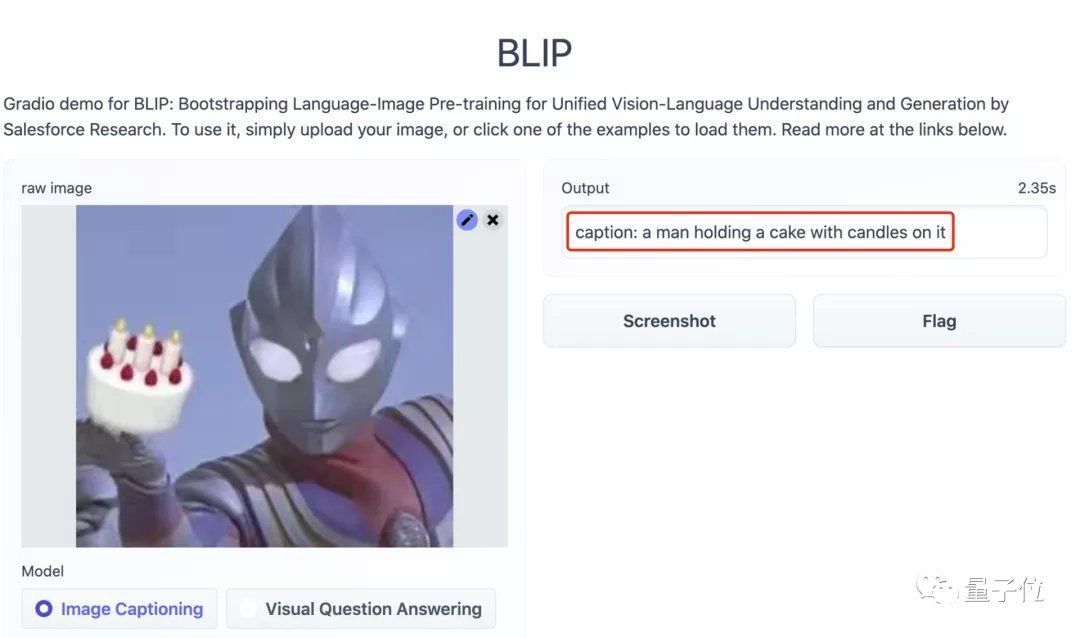

即便是上传一张恶搞的奥特曼图片,也没有难倒BLIP,并且还给出了一个一本正经的回答:

一个男人端着一个插有蜡烛的蛋糕。

文章插图

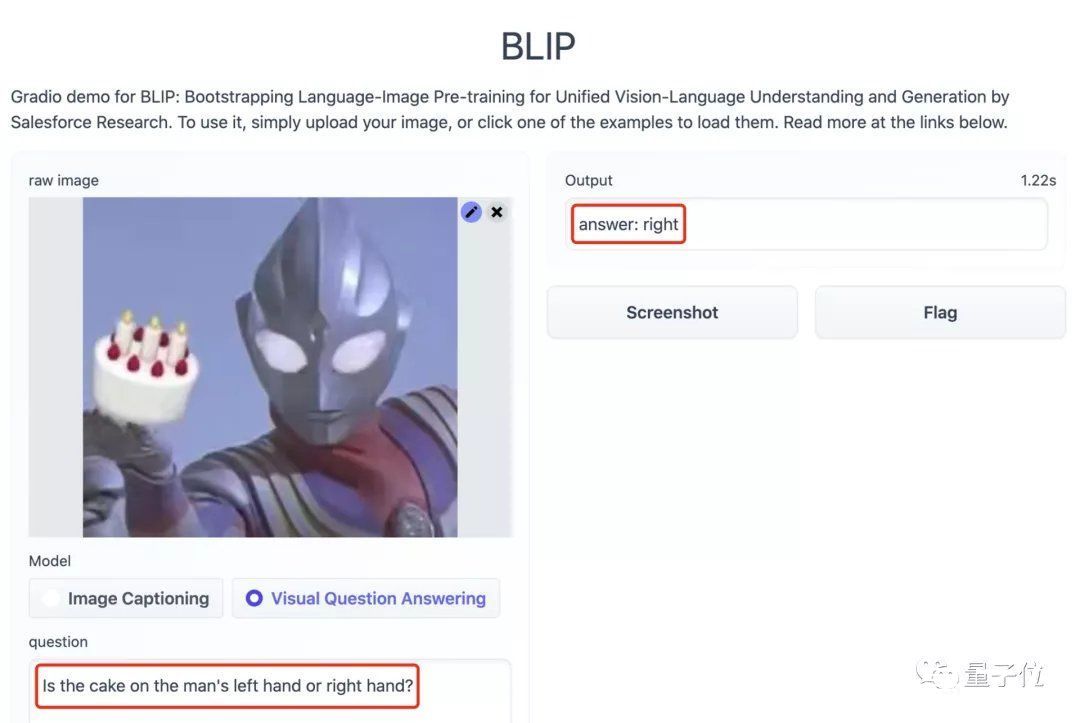

甚至问它:蛋糕是在男人的左手上还是右手上?BLIP都能给出正确的答案:

右手。

文章插图

这波操作属实是6到我了。

【 标注|一个模型搞定图像标注、读图问答两件事,VQA准确率逼近人类水平】那么它背后的原理是什么呢?我们一起来看。

学习带噪图像-文本对BLIP这次主要做的工作有两方面。

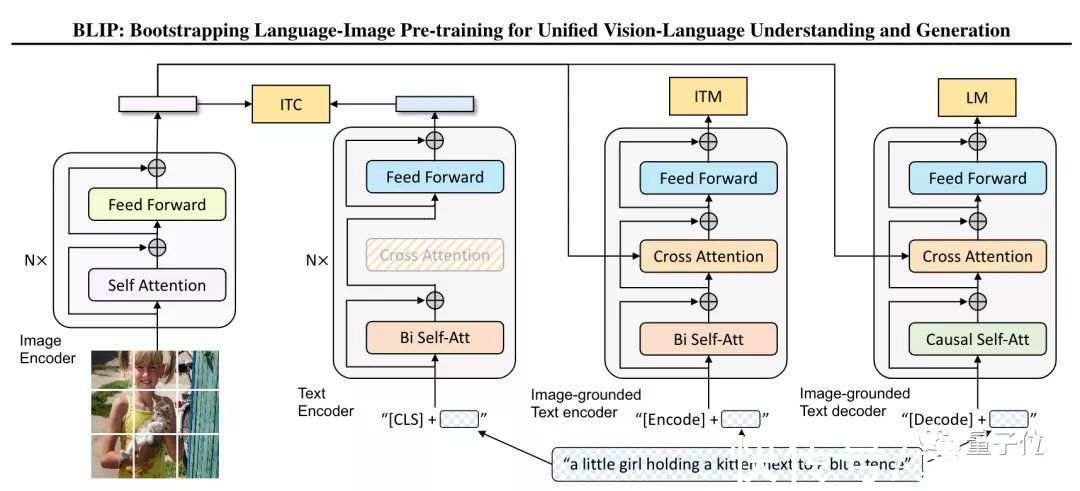

第一,它使用了一个多任务模型(MED),将多种任务预训练整合在了一起。

文章插图

从框架图中看到,MED主要包括3个部分:

单峰编码器,可以用图像-文本对比损失(ITC)训练,让视觉和文本表征对齐。

基于图像的文本编码器,可以用传统的交叉注意层来模拟视觉-语言信息的转换,并通过图像-文本匹配损失(ITM)来进行训练,从而来区分正、负图像-文本对。

基于图像的文本解码器,可以将双向自注意力层转换为因果自注意力层,并且与编码器共享同一个交叉注意力层和前馈网络。解码器通过语言建模训练(LM)来输出文字标注。

由此,该模型可以执行图像-文本对比、图像-文本匹配和图像语言生成任务。

第二方面,研究人员提出了一种新型的数据自举法(CapFilt)。它可以让模型从带有噪声的图像-文本对中学习。

- 复盘|复盘总结近期的一个人工智能物联网(AIoT)项目?

- 程序员|有的软件公司宁愿花15k去重招一个应届生,也不加薪5k留住公司老程序员

- Redmi K50电竞版发布会邀请函图赏,内含AMG赛车模型

- 亚马逊|原理简单,但不知道怎么用?一文看懂「同期群模型」

- 团购|社区团购“最惨烈”的一年,下一个倒下的会是它吗?

- ARM|CEO离职,ARM收购案彻底失败!英特尔却用64亿做出一个意外举动

- 骁龙8 Gen 1“翻车”?搭载该芯片手机上市一个月,降价700元!

- 如果你有一个天才孩子,该怎么教育?

- 钱包即将保不住!情人节想送一个“口红”给女神,可惜支付不起

- 浏览器|浏览器的复杂程度,可以和一个操作系统媲美