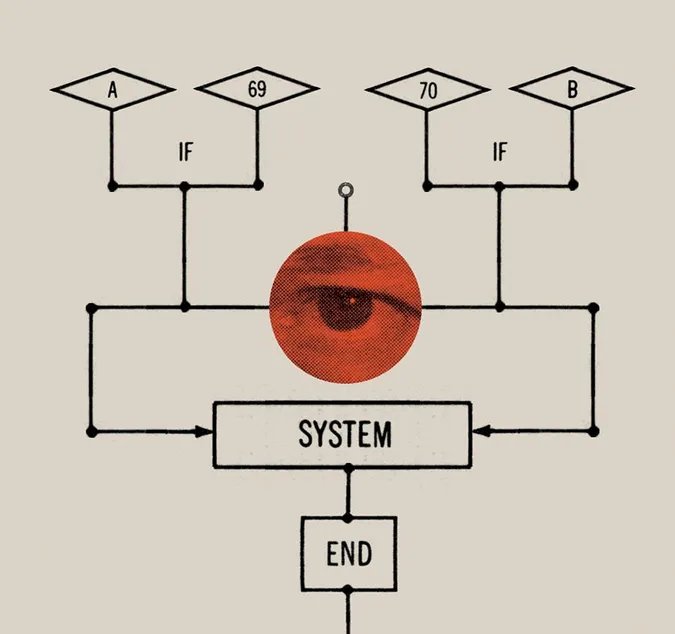

随着面部识别、生物识别、基因组数据分析等技术兴起。安德鲁?罗恩担心:“我们有时候并没有意识到大数据跟踪和监视技术的不断发展,会使我们进入了未知的危险领域。”数据一旦被收集和分析,其作用就会远远超出跟踪和监视的功能,例如AI的预测性控制功能。今天,AI系统可以预测我们将购买哪些产品,我们将观看哪些娱乐节目,以及我们将点击哪些链接。当这些平台比我们自己更了解我们时,我们可能不会注意到这种微小的变化,但它剥夺了我们的自由意志并使我们受到外部力量的控制。

文章插图

而这个实验的观察数据,以及后期对这些孩子的追踪观察说明:

那些延迟满足能力强的孩子,自我控制能力也就越强,可以在没有外界监督的情况下,自主性的控制调节自身行为,在某一个任务完成程度上,要更胜一筹。

当前,具备延迟满足能力孩子也会屈服于AI算法给出的诱惑。

进一步,社交媒体用户已经成为实验室中的老鼠,生活在斯金纳盒子里。这些用户沉迷于手机,被迫牺牲更多宝贵的时间和注意力在数字平台上。

海伦·托纳认为:“算法经过优化,可使用户尽可能长时间地‘留’在平台上。”著名作家马尔科姆·默多克解释道:“通过以喜欢,评论和关注的形式提供奖励,算法会缩短我们大脑的工作方式,让我们不自觉地去参与下一个。”

为了最大化广告利润,公司把我们的注意力从工作、家人、朋友,责任甚至爱好上转移。更糟糕的是,如果推送内容质量下降,用户会痛苦和暴躁。海伦·托纳警告:“我们在平台上花费的时间越多,花在追求积极、高效和充实生活上的时间就越少。”

当前,许多AI系统没有考虑到不同人的不同经历和特征,AI模型的训练往往基于有偏见的观点和数据,无法充足考虑每个人的独特需求来解决问题,因此此类系统在人类社会中缺乏一致性。甚至在AI大规模应用之前,对日常生活中常见物品的设计往往也是迎合了特定类型的人。例如,研究表明,汽车、包括手机在内的手持工具,甚至办公室环境中的温度设置都是为适合中等身材的男性而设置的,这使得包括女性在内的各种身材和体型的人处于劣势,有时甚至会对他们生活造成危害。

当不属于有偏见规范的个人被忽视、边缘化和排斥时,AI就会变成卡夫卡式的守门人:拒绝提供客户服务、工作、医疗等服务,这些设计决策的目的约束人们,而不是将他们从日常事务中解放出来。此外,这些选择还可以将一些最恶劣的偏见转化为种族主义和性别歧视,造成严重缺陷和有偏见的判决结果。

- 阿里巴巴|继当选IEEE Fellow之后,阿里云李飞飞又新晋ACM Fellow

- Fellow|继当选IEEE Fellow之后,阿里云李飞飞又新晋ACM Fellow

- 蚂蚁集|IEEE正式推行首个隐私保护机器学习国际标准 蚂蚁集团参与制定

- IEEE全票通过,首个隐私保护机器学习国际标准正式推行

- 大数据|IEEE Fellow李世鹏 :人工智能与机器人前沿研究之思考

- 上科大、IEEE Fellow 虞晶怡:我眼中的城市元宇宙 |第四届中国人工智能安防峰会

- G论智三易,串联通讯,贯通边缘,演进认知,汇于机器:听五位IEEE Fellow畅谈 gai

- SIGS科研|信息学部论文入选IEEE计算机与通信国际会议

- 领域|IEEE Fellow梅涛:视觉计算的前沿进展与挑战

- 分布式系统|IBM Spectrum LSF: 分布式系统的“瑞士军刀”