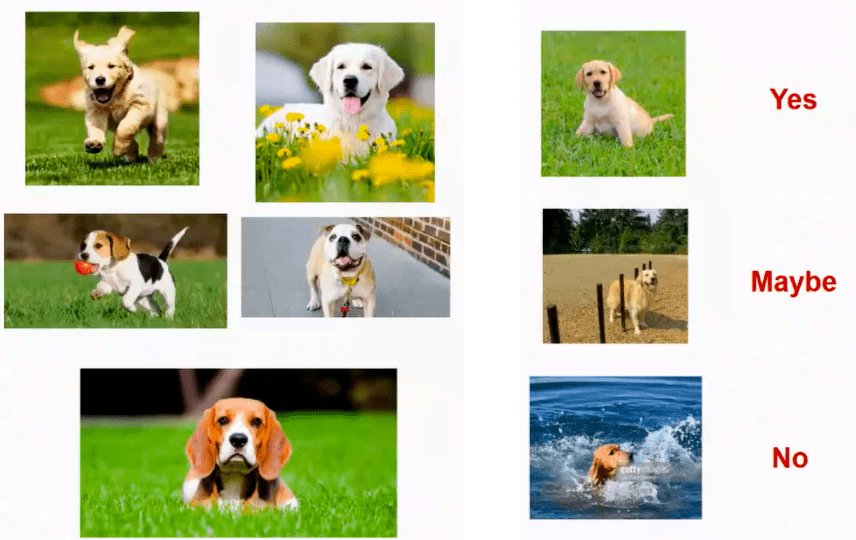

(Susan 2017年为《Science》撰写的综述性文章)在机器学习过程中带来的关联统计被认为是导致目前的机器学习缺乏可解释性和稳定性的重要原因。现有的大部分机器学习方法都需要IID假设,即训练数据和测试数据应当是独立同分布的。然而在现实中这一假设很难满足。以我们熟悉的图片“猫狗检测”为例,如果训练数据的大部分图片中狗位于草地上,模型对“水中的狗”这一极端样例的检测可能会完全失效,甚至可能出现“指猫为狗”的错误,把在草地上的猫错认为狗。

文章插图

当下的人工智能技术往往不能很好地泛化到未知的环境,是因为现有大部分机器学习模型主要是关联驱动的,这些模型通常只做到了知其“然”(即关联性)而不知其“所以然”(即因果性)。将因果推理的思想推广到机器学习领域,去除关联中的虚假关联,使用因果关联指导模型学习,是提升模型在未知环境下稳定性根本路径之一。值得一提的是,从因果角度出发,可解释性和稳定性之间存在一定的内在关系,即通过优化模型的稳定性亦可提升其可解释性,从而解决当前人工智能技术在落地中面临的困境。基于此,清华大学崔鹏团队从2016年起开始深入研究如何将因果推理与机器学习相结合,并最终形成了“稳定学习”(Stable Learning)的研究方向。稳定学习有望弥补机器学习模型的“预测”到经济生活等现实“决策”之间的鸿沟,随着对因果分析研究的进一步深入,以稳定学习为代表的因果分析建模技术将成为人工智能发展的突破口,帮助我们从数据中推断出因果关系并进行有效检验,从而做出更好的决策。因果推理近年来在机器学习和人工智能领域引起了广泛关注。它通常被定位为一个独特的研究领域,可以将机器学习的范围从预测建模扩展到干预和决策。而从作者的角度来看,即便对于机器学习所擅长的预测类问题,如果对预测稳定性、可解释性和公平性提出较高要求,那么因果统计的思想对于改善机器学习、预测建模也变得不可或缺。基于此,作者提出了稳定学习的概念和框架,以弥合因果推理中传统精确建模与机器学习中的黑盒方法之间的鸿沟。本文阐明了机器学习模型的风险来源,讨论了将因果关系引入机器学习的必要性,从因果推理和统计学习两个视角阐述了稳定学习的基本思想和最新进展,并讨论了稳定学习与可解释性和公平性问题的关系。

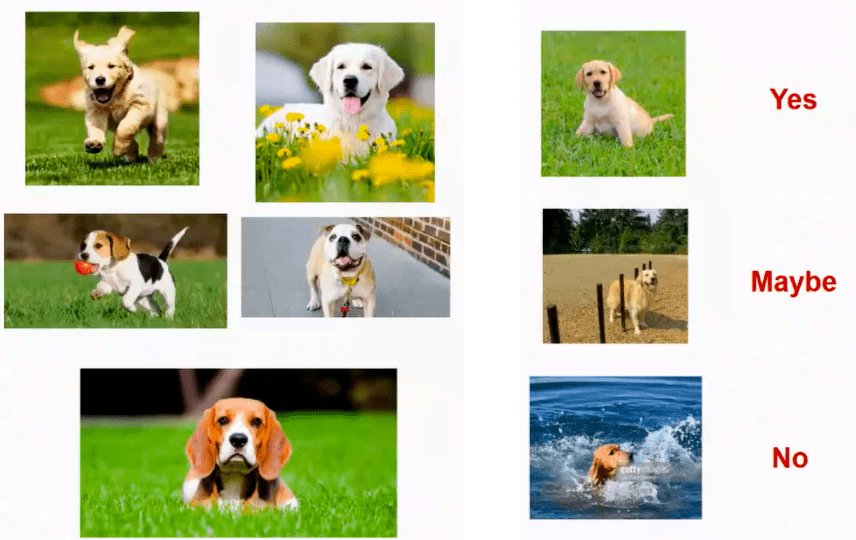

文章插图

论文指出,机器学习技术的优化目标是预测的精度和效率,而错误预测的潜在风险往往被忽视。对于预测点击量或对图像进行分类等应用,模型可以频繁更新,错误的代价也不会太高。因此,这些应用领域非常适合结合持续性能监控的黑盒技术,这也是近年来机器学习得以快速发展的基础。然而,近年来机器学习被应用于医疗健康、工业制造、金融和司法等高风险领域,在这些领域,机器学习算法犯下的错误可能会带来巨大的风险。尤其是当算法预测在决策过程中发挥重要作用时,错误会对安全、道德和正义等社会问题产生重大后果。因此,缺乏稳定性、可解释性和公平保障是当今机器学习中亟需解决的最关键和最紧迫的议题。