中国科学院|AAAI 2022大奖出炉!中科院德州扑克程序AlphaHoldem获卓越论文奖( 二 )

但目前主流德州扑克AI背后的核心思想是利用反事实遗憾最小化(Counterfactual Regret Minimization, CFR)算法逼近纳什均衡策略。

具体来说,首先利用抽象(Abstraction)技术[3][7]压缩德扑的状态和动作空间,从而减小博弈树的规模,然后在缩减过的博弈树上进行CFR算法迭代。

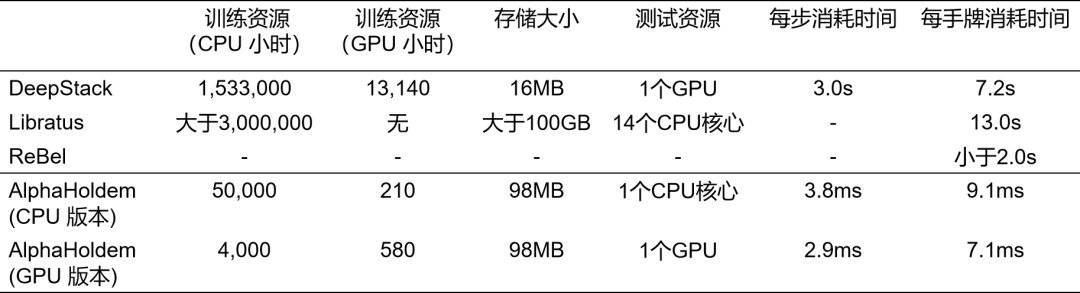

这些方法严重依赖于人类专家知识进行博弈树抽象,并且CFR算法需要对博弈树的状态结点进行不断地采样遍历和迭代优化,即使经过模型缩减后仍需要耗费大量的计算和存储资源。例如,DeepStack使用了153万的CPU时以及1.3万的GPU时训练最终AI,在对局阶段需要一个GPU进行1000次CFR的迭代过程,平均每个动作的计算需耗时3秒。Libratus消耗了大于300万的CPU时生成初始策略,每次决策需要搜索4秒以上。

这样大量的计算和存储资源的消耗严重阻碍了德扑AI的进一步研究和发展;同时,CFR框架很难直接拓展到多人德扑环境中,增加玩家数量将导致博弈树规模呈指数增长。另外,博弈树抽象不仅需要大量的领域知识而且会不可避免地丢失一些对决策起到至关作用的信息。

文章插图

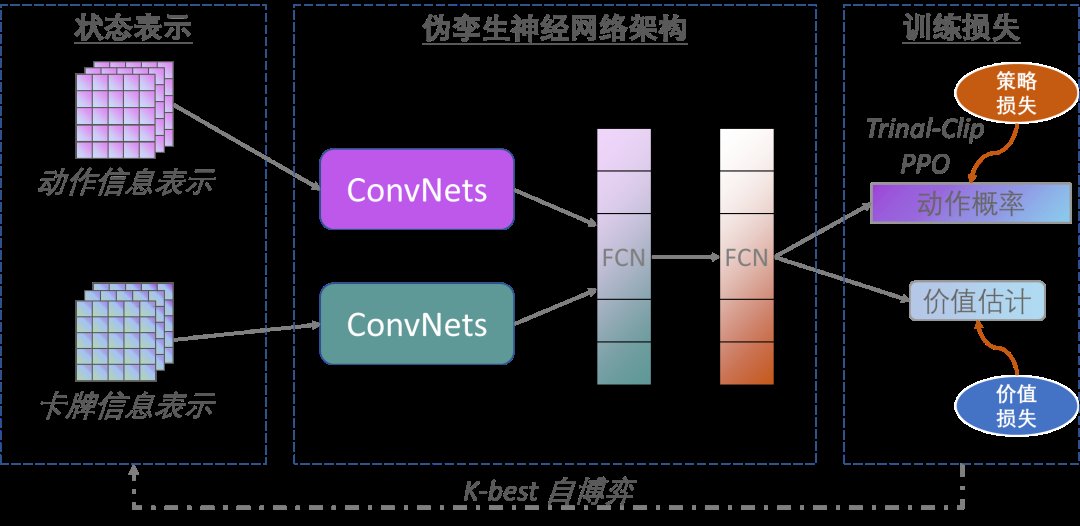

不同于已有的基于CFR算法的德州扑克AI,中科院博弈学习研究组所提出的架构是基于端到端的深度强化学习算法(如图4所示)。

文章插图

根据团队介绍,AlphaHoldem采用Actor-Critic学习框架,其输入是卡牌和动作的编码,然后通过伪孪生网络(结构相同参数不共享)提取特征,并将一种改进的深度强化学习算法与一种新型的自博弈学习算法相结合,在不借助任何领域知识的情况下,直接从牌面信息端到端地学习候选动作进行决策。

他们还指出,AlphaHoldem的成功得益于其采用了一种高效的状态编码来完整地描述当前及历史状态信息、一种基于Trinal-Clip PPO损失的深度强化学习算法来大幅提高训练过程的稳定性和收敛速度、以及一种新型的Best-K自博弈方式来有效地缓解德扑博弈中存在的策略克制问题。

AlphaHoldem 使用了1台包含8块GPU卡的服务器,经过三天的自博弈学习后,战胜了Slumbot和DeepStack。每次决策时,AlphaHoldem都仅用了不到3毫秒,比DeepStack速度提升超过了1000倍。同时,AlphaHoldem与四位高水平德州扑克选手对抗1万局的结果表明其已经达到了人类专业玩家水平。

文章插图

文章插图

兴军亮,中国科学院自动化研究所研究员、博士生导师、特聘青年骨干,中国科学院大学岗位教授,中国科学院人工智能创新研究院创新专家组专家。兴教授2012年毕业于清华大学计算机科学与技术系,获工学博士学位。

- 本文转自:中国网2022新年伊始|万亿级市场预制菜也开始内卷,品牌如何在激烈竞争中脱颖而出?

- 院长|一箭22星,如何做到的

- ces|MWC 2022:TCL疯狂输出 推出TCL 30系列5款手机

- 联想2022拯救者生态春季新品发布会 看点全在这里

- 努比亚是成立于2012年的手机品牌|2022年上半年最顶级的安卓旗舰手机努比亚z40pro

- ROG 推出 2022 款幻 15 笔记本:R7 6800HS + RTX 3060

- 本文转自:文汇客户端2022年2月27日11时06分|武大首颗学生自研微纳卫星成功发射!收到遥测信号,卫星工作正常

- mac pro|2022 年 Apple 的 Mac Pro 更新

- 扩大智慧办公新版图,华为面向全球发布七款终端新品 | MWC2022

- 高通骁龙|2022年了,买骁龙870是智商税吗?